ℹ️ 빠르게 발전중인 생성 AI 기술 중 그 주의 가장 주목할만한 모델만 큐레이션해서 보내드리는 뉴스레터에요. ✉️

ℹ️ 최신 논문과 연구 사례를 살펴보고 생성 AI 기술의 발전 동향을 미리 파악하고 대비할 수 있어요. 🧑💻

ℹ️ 어려운 기술 용어 지양하고 데모 영상 위주로 전달드려요. 데모 영상은 웹페이지에서 재생 가능해요. 📺

Style-NeRF2NeRF

- 이 방법은 2D 이미지 모델을 사용하여 여러 이미지로 만든 3D 장면에 예술적 스타일을 적용합니다.

- 사용자는 3D 모델을 완성하기 전에 다양한 스타일을 미리 보고 실험해 볼 수 있습니다.

- Style-NeRF2NeRF는 다양한 예술적 스타일을 경쟁력 있는 품질로 실제 3D 장면에 효과적으로 전송합니다.

데모 영상👇

Style-NeRF2NeRF: 3D Style Transfer from Style-Aligned Multi-View Images

EvTexture

- EvTexture는 향상된 비디오 처리를 위해 높은 시간적 해상도와 높은 동적 범위 특성을 활용합니다.

- 고주파 디테일 복구에 중점을 두고 이벤트 신호를 사용하여 비디오 초고해상도(VSR)의 텍스처를 향상합니다.

- 점진적 텍스처 개선을 위한 새로운 모듈을 도입하여 더욱 풍부하고 정확한 고해상도 텍스처를 구현합니다.

데모 영상👇

EvTexture: Event-driven Texture Enhancement for Video Super-Resolution

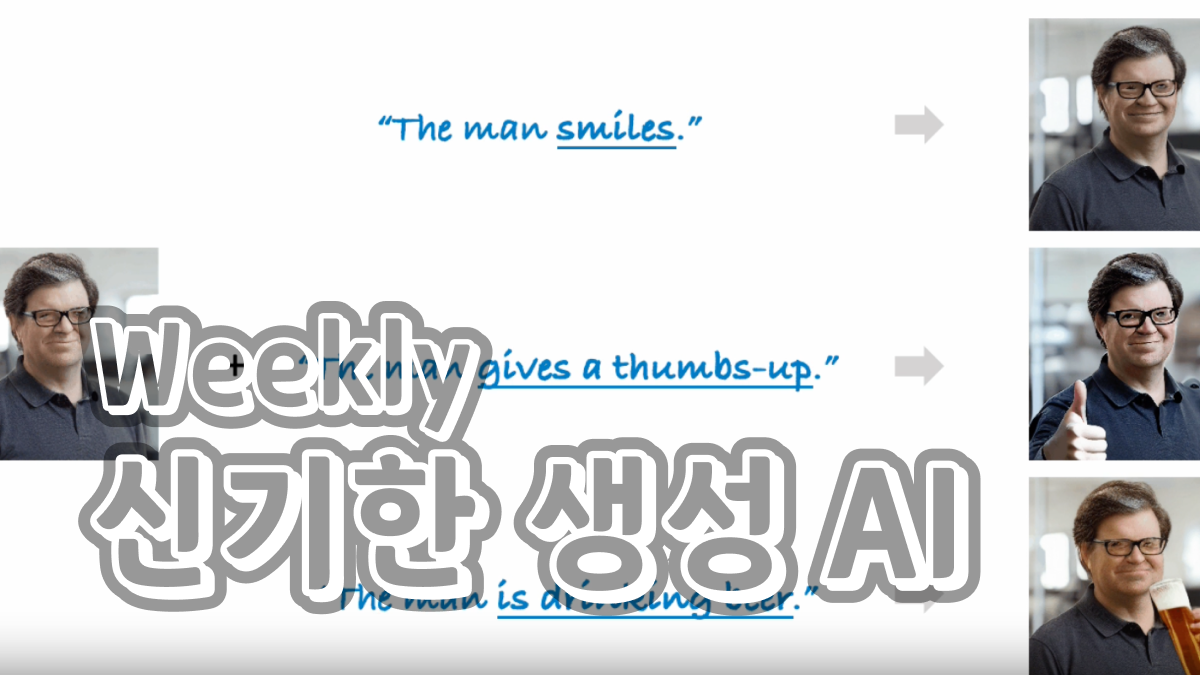

MOFA-Video

- MOFA-Video는 사람의 랜드마크, 수동 경로 또는 다른 동영상과 같은 다양한 제어 신호를 사용하여 이미지에서 동영상을 생성합니다.

- 특수 어댑터를 사용하여 부드럽고 일관된 모션과 안정적인 비디오 출력을 보장합니다.

- 여러 제어 신호를 결합하여 보다 정밀한 동영상을 제작할 수 있습니다.

MOFA-Video: Controllable Image Animation via Generative Motion Field Adaptions in Frozen Image-to-Video Diffusion Model

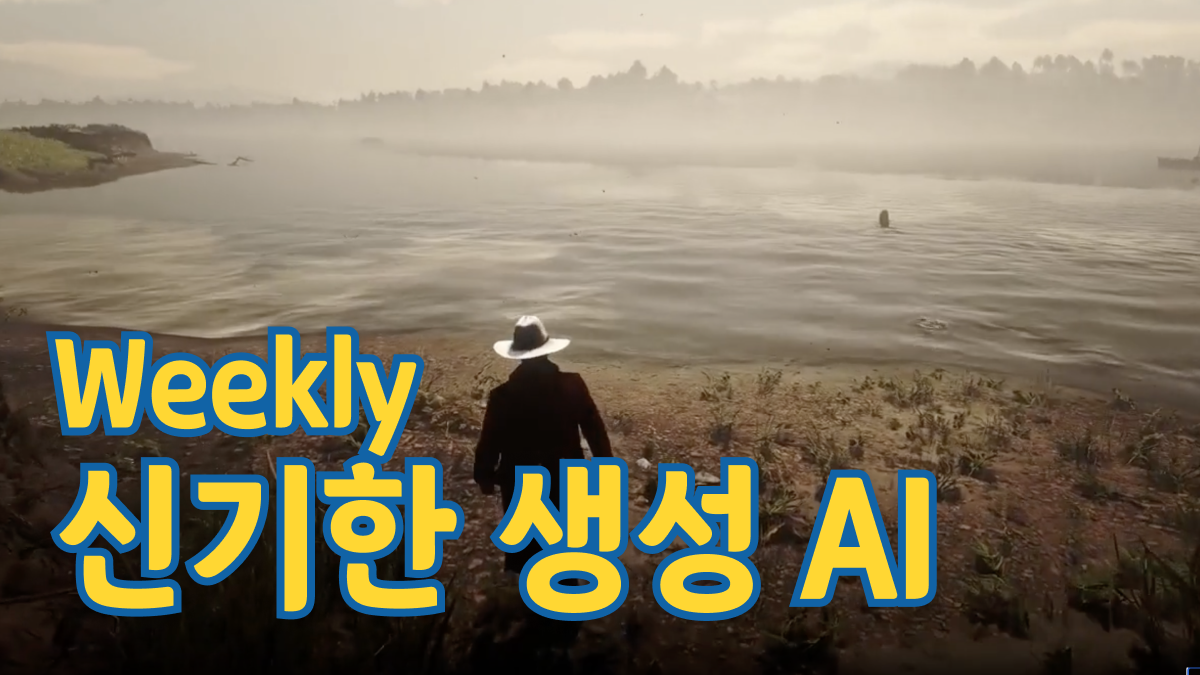

ExVideo

- ExVideo는 포스트 튜닝 기법을 사용하여 안정적인 비디오 확산과 같은 모델을 향상시켜 비디오 생성 용량을 최대 5배까지 확장합니다.

- 이 방법은 4만 개의 비디오로 구성된 데이터 세트를 학습하는 데 1.5k GPU 시간만 필요하므로 비용 효율적입니다.

- ExVideo는 성능 저하 없이 다양한 스타일과 해상도를 생성하여 모델의 품질과 다양성을 유지합니다.

데모 영상👇

ExVideo: Extending Video Diffusion Models via Parameter-Efficient Post-Tuning

Flash Diffusion

- Flash Diffusion은 기존 방법보다 더 적은 학습 시간과 리소스로 주요 벤치마크(FID 및 CLIP-Score)에서 최고의 성능을 달성합니다.

- 이 방법은 텍스트-이미지 변환, 인페인팅, 얼굴 스와핑, 초고해상도 등의 작업 전반에 걸쳐 잘 작동하는 다목적 방법입니다.

- 플래시 확산은 고품질 이미지를 생성하는 데 필요한 단계 수를 줄여 프로세스를 더 빠르고 리소스 효율적으로 만듭니다.

데모 영상👇

Flash Diffusion: Accelerating Any Conditional Diffusion Model for Few Steps Image Generation

의견을 남겨주세요