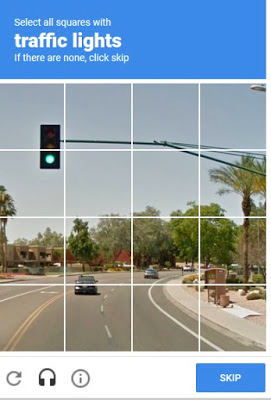

인간이 인공지능을 테스트하는 것이 아니라, 인공지능이 인간을 역으로 테스트하는 시대가 왔다. 인공지능은 무례하게 이렇게 요구한다. 당신이 인간이 맞다면 신호등이 포함된 타일을 모두 고르시오!

여기서 문제, 왼쪽 두 개는 확실히 신호등이 포함됐으니 클릭한다고 하고 신호등을 매달고 있는 기둥은 신호등인가 아닌가? 만약 기둥을 신호등의 연장선으로 본다면 가로로 길게 뻗은 타일을 모두 클릭해야 하는데 틀릴까봐 망설여진다. 혹시 내가 자동으로 이메일에 가입하고, 스팸이나 나르고 있는 인공지능 봇으로 취급될까 두렵다!

의견을 남겨주세요