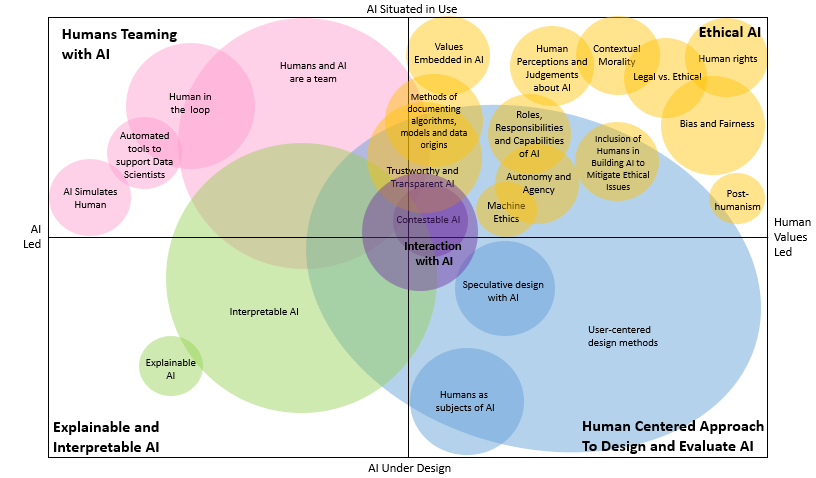

Human-centered AI 관련하여 첫번째 주제로 잡은 Ethical AI에 대한 이해를 돕기 위해, 2021년 발표되어 3천 회 이상 인용된 논문 A survey on bias and fairness in machine learning 내용을 간단히 요약하고 저희의 의견을 덧붙여보았습니다.

Mehrabi, N., Morstatter, F., Saxena, N., Lerman, K., & Galstyan, A. (2021). A survey on bias and fairness in machine learning. ACM computing surveys (CSUR), 54(6), 1-35. [Link]

일상생활에서의 AI 시스템 사용이 늘어남에 따라, 이로 인한 결정이 차별적이거나 편견을 반영하지 않도록 하는 것이 매우 중요해지고 있습니다. 본 논문에서는 다양한 방식으로 편견을 보여준 다양한 시스템들을 조사하고, 이 편견이 어디에서부터 발생한 것인지 그 소스를 파악하고자 하였습니다. 그리고 '편견'이라는 개념을 명확히 하기 위해 기존에 정의된 'Fairness(공정성)'에 대해 분류하였습니다.

Bias(편견)이 발생하는 단계

Data to Algorithm

Measurement bias - 특정 내용을 측정하기 위한 변수를 선택, 활용 및 측정하는 방법에서 일어나는 편견 예) 재범 위험 예측 도구인 COMPAS에서 범죄 수준을 측정하기 위한 변수로 '이전 체포', '친구 및 가족의 체포'가 사용되었으나 이는 소수자 집단의 체포율이 더 높은 기존 데이터를 활용했을 때에 차별적인 결론을 제공할 수 있음.

Omitted variable bias - 알고리즘을 설계할 때에 미처 고려하지 못했던 변수가 추후에 실제로 발생한다면, 이와 같이 생략된 변수로 인한 편견 발생 가능.

Representation bias - 대표성이 없는 표본 데이터를 활용하였을 때 이로 인해 발생할 수 있는 편견.

Sampling bias - 랜덤하지 않은 샘플링으로 인한 편견.

Longitudinal data Fallacy - 시간의 흐름을 반영하지 않은 데이터로 인한 편견.

Linking bias - 특정 데이터를 반영하는 링크를 고려하지 않을 때 발생하는 편견.

Algorithm to User

Algorithm bias - 입력 데이터에는 편향이 존재하지 않지만 선택한 알고리즘 설계 자체로 인해 편향이 발생하는 경우.

User interaction bias - 시스템 인터페이스 혹은 사용자의 행동 자체로 인한 편향 발생. 예) 결과값의 일부가 숨겨져 있거나 추가적인 클릭을 통해서 접근 가능할 때, 노출된 결과값만 받아들이게 되는 편향

Popularity bias - 인기있는/유명한 아이템이 더 많이 노출됨으로 인한 편향 발생.

Emergent bias - 시스템 설계 후 시간이 흘렀을 때 인구, 문화적 가치 혹은 사회적 지식의 변화로 인한 편향 발생.

Evaluation bias - 모델 평가 중 부적절한 지표를 활용하여 평가하고 이를 반영할 때 나타나는 편향.

User to Data

Historical bias - 역사적으로 이미 세상에 존재하는 편향으로 데이터 생성 과정에 자연스럽게 녹아드는 편향.

Population bias - 인구 통계적인 편향으로 역시 자연스럽게 데이터 생성 과정에 들어갈 수 밖에 없는 편향.

Self-selection bias - 여론 조사에서 가장 열정적인 사람들의 참여가 많을 수 밖에 없고 그들의 의견이 결론에 반영됨에 따라 나타나는 편향.

Social bias - 타인의 시선이 판단에 영향을 미침으로 인해 발생하는 편향. 예) 레스토랑 리뷰를 할 때 낮은 점수를 주려다가도 타인의 평가가 너무 높으면 자신의 점수를 높게 바꾸는 경우

Behavioral bias - 플랫폼 혹은 컨텍스트에 따라 사용자 행동이 달라짐으로 인해 발생하는 편향. 예)플랫폼별로 주로 사용하는 이모티콘의 차이로 인해 사람들의 반응이 달라짐

Temporal bias - 시간이 지남에 따라 행동의 차이가 일어남으로 인한 편향.

Content production bias - 컨텐츠의 어휘, 의미 차이로 인해 발생하는 편향. 예) 성별 혹은 연령층에 따라 사용하는 언어의 차이로 인한 편견

Discrmination (차별)

Bias가 데이터 수집, 샘플링, 측정으로 인해 발생하는 불공정의 원인이라면Discrimination은 사람의 편견 및 고정관념으로 인해 발생하는 불공정의 원인

설명 가능한 차별 - 그룹간의 차이를 설명가능하여 이를 정당화할 수 있는 경우예) 평균적으로 남성이 여성보다 연간 소득이 높게 나타나는데, 이는 평균적으로 남성보다 여성의 업무 시간이 적기 때문이다. 이를 고려하지 않고 남성과 여성의 연간 소득을 맞춰주려고 하면 남성의 시간당 근로소득이 여성보다 낮아지게 되기 때문에 역차별로 이어질 수 있음.

설명 불가능한 차별 - 집단에 대한 차별이 부당하여 불법으로 간주되는 경우 예) 개인의 거주지 우편번호가 대출 여부를 결정하는 과정에 사용될 수 있음. 이는 민감하지 않은 속성으로 보여서 데이터에 포함되나, 주거 지역의 인구 속성으로 인해 인종과 연관될 수 있기 때문에 인종 차별로 이어질 수 있음

알고리즘의 공정성

Bias와 Discrimination을 없애기 위해서는 이와 반대되는 개념인 Fairness(공정성)을 정의하는 것이 중요합니다. AI 알고리즘을 '공정하게' 만들기 위한 제약 조건을 제안하는 많은 연구들이 존재하지만, 어떤 제약조건이 가장 중요한지에 대한 명확한 합의가 이루어지지 않은 상태입니다.

'공정한' 머신 러닝을 위한 방법론

각 방법론이 적용되는 단계가 어디쯤인가에 따라 데이터 전처리, 모델 트레이닝 프로세스 중 알고리즘 내 존재하는 차별을 수정(예. Fairi classification, Fair regression 등), 그리고 후처리 방식으로 나누어집니다.. 하지만 다양한 방법론 중 우위에 있는 절대적인 방법론이 존재하지 않으며, 실제로 존재하는 데이터 자체가 가지고 있는 편향을 어디까지 인간이 개입하여 제거할것인가에 대한 논의가 지속적으로 이루어지고 있는 것이 현실입니다..

리뷰

본 연구에서는 편견과 불공정성 측면에서 AI 시스템에 악영향을 미칠 수 있는 문제점을 소개했습니다. 편견과 차별이 발생할 수 있는 원인을 체계적으로 분석하고 기존에 논의되어온 공정성의 정의를 정리하였다는 측면에서 그 의미가 있습니다.

하지만 실제 이를 해결할 수 있는 방법론은 저자가 언급하였듯이 그 어느것도 절대적으로 우세하지 않으며 각각의 측면 일부만 해결할 수 있다는 한계점이 존재합니다.

공정한 AI를 위한 절대적인 방법론은 현재 존재하지 않지만, 이의 중요성은 모두가 이미 동의하고 있습니다. 때문에 AI를 만드는 사람들부터 AI를 사용하는 사람들까지 모두가 Ethical AI라는 개념을 잘 이해하고 이에 적합하지 않은 사례가 있을 때 지속적으로 의문을 제기하는 것이 앞으로 문제 해결책을 찾아나가는 데에 큰 원동력이 될 수 있을 것이라 생각합니다.

의견을 남겨주세요