이 논문은 사용자 맞춤형 차량 내 시스템에 설명 가능성을 통합하는 것에 초점을 맞추고 있습니다. 이 연구는 사용자가 AI 기반 사용자 맞춤형 시스템에서 제공하는 설명을 어떻게 평가하는지, 그리고 이러한 설명이 사용자 수용, 신뢰 및 시스템 투명성에 어떤 영향을 미치는지를 조사합니다.

연구 방법

- 목표: 지능형 차량에서 사용자 적응형 편의성 및 인포테인먼트 기능의 설명 가능성이 최종 사용자에게 어떻게 인식되는지 평가

- 연구에 사용된 프로토타입:

- 정보 제공 및 설명 컨셉트(I&E 컨셉트): 기본 정보 외에도 적응이 이루어진 이유와 알고리즘이 결과에 도달한 방법을 설명

- 정보 제공 컨셉트(I 컨셉트): 시스템이 만든 적응에 대한 기본 정보를 제공

- 사용 사례: 차량의 편의성 및 인포테인먼트에 대해 일반적인 다양한 기능을 포함하기 위해 네 가지 다른 사용 사례(내비게이션, 기후 조절, 중간 정차, 엔터테인먼트)가 프로토타입에 구현되었습니다.

- 연구 설계: 참가자들은 (평균 나이 39세인 59명; 여성 51%, 남성 49%) 시뮬레이션 환경에서 두 개념(I 및 I&E)을 경험했습니다. 수용도, 신뢰도, 설명의 가치, 이해도/투명성과 같은 종속 변수를 측정하기 위해 다양한 설문지가 사용되었습니다.

주요 결과

1. 전반적 평가

- I&E 개념은 인식된 투명성 및 이해도 측면에서 유의미하게 더 높게 평가되었습니다.

- 그러나 I&E 개념에 대한 만족도는 I 개념에 비해 낮았습니다.

- 대부분의 참가자들은 간결하고 효율적인 정보를 선호하여 I 개념을 더 선호했습니다.

2. 이해도 및 투명성

- I&E 개념은 이해도 및 투명성에서 더 높은 점수를 받았습니다.

- 그러나 시스템 이해에 대한 객관적 평가는 이러한 주관적 평가와 완전히 일치하지 않았습니다.

3. 설명의 가치

- I&E 개념의 설명은 일반적으로 가치 있다고 인식되었으며, 특히 내비게이션 및 중간 정차 사용 사례에서 더 높은 가치가 인식되었습니다.

의의

- 사용자 선호도에 대한 통찰: 이 연구는 인공 지능 시스템에서 설명의 길이와 복잡성을 균형있게 다루는 것이 중요하다는 것을 강조하며, 사용자들은 간결하고 효율적인 정보를 선호한다는 것을 보여줍니다.

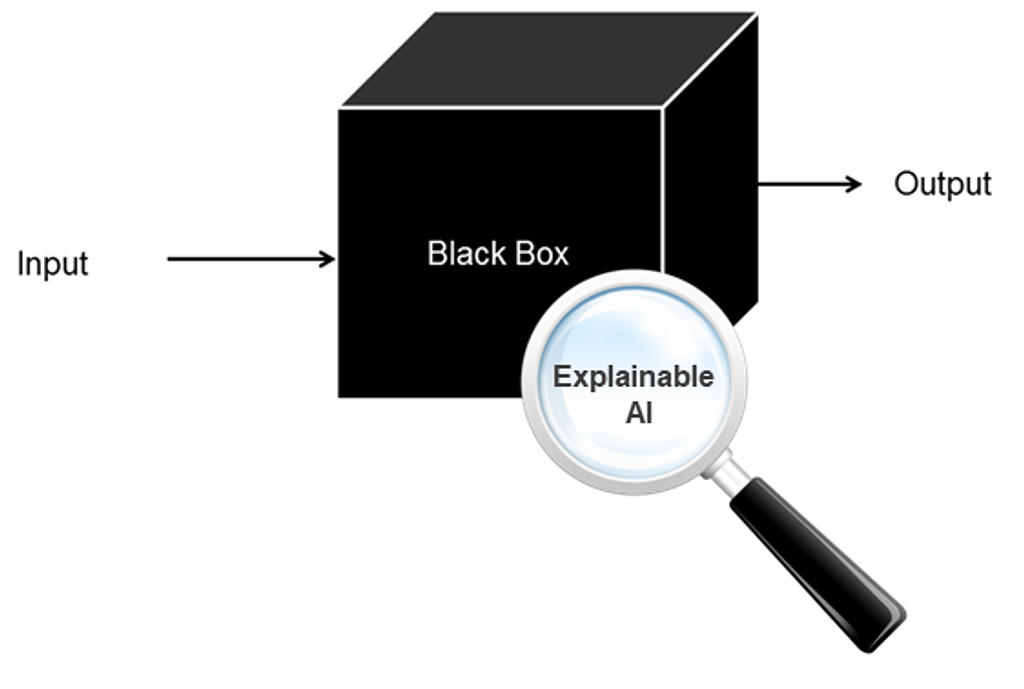

- 설명 가능한 AI에 대한 함의: 이 연구의 결과는 설명이 인식된 투명성 및 이해도를 향상시키지만, 항상 시스템에 대한 더 나은 객관적 이해로 이어지지는 않는다는 것을 시사합니다. 이는 설명의 설계 및 통합에 신중을 기해야 함을 나타냅니다.

- 특징에 따른 설명 필요성: 연구는 설명이 필요한 정도가 기능에 따라 다르다는 것을 제시하며, 일부 기능은 높은 수준의 투명성을 요구한다고 제안합니다.

- 미래 차량 설계에 대한 지침: 이러한 발견은 지능형 차량의 사용자 인터페이스를 설계할 때 유용한 통찰을 제공합니다. 또한, 설명 가능한 AI에서 사용자 중심 접근과 특징별 설명 전략의 필요성을 강조합니다.

결론적으로, 이 연구는 지능형 차량 시스템에서 사용자 중심의 설명 가능성이 중요하다는 실증적 증거를 제공하며, 설명은 인식된 투명성과 이해도를 향상시키지만, 사용자의 필요와 선호를 효과적으로 충족시키기 위해서는 그 설계와 통합에 신중을 기해야 함을 시사합니다.

의견을 남겨주세요

동동이

논문 내용이 흥미로워 보여요! 전문 읽어보고 싶은데 어디서 보면 좋을까요?

inspireX

안녕하세요. 논문은 아래 링크에서도 확인하실 수 있습니다! https://web.archive.org/web/20220918094713id_/https://dl.acm.org/doi/pdf/10.1145/3543174.3546846

의견을 남겨주세요