🔍 1. 오픈AI, GPT-5 출시 연기 및 'o3'·'o4-mini' 모델 우선 출시

📝 한 문장 요약

오픈AI는 GPT-5 출시를 몇 달 뒤로 연기하고, 대신 추론 능력이 향상된 'o3'와 'o4-mini' 모델을 몇 주 내에 출시할 계획입니다.

📌 팩트체크

알트먼은 X(구 트위터)를 통해 이러한 계획 변경을 직접 언급했습니다.

📌 사실 가능성 ★★★★★ (5/5)

CEO의 공식 발표에 따른 계획으로, 신뢰할 수 있습니다.

📌 기사 정확도 ★★★★★ (5/5)

📌 앞으로 얻을 인사이트

- 모델 통합 전략: 오픈AI는 기능별 특화 모델을 먼저 출시한 후, 이를 통합한 GPT-5를 선보일 계획입니다.

- 추론 능력 강화: 새로운 모델들은 특히 추론 능력 향상에 초점을 맞추고 있습니다.

📌 How-to 전략

- 새로운 모델 테스트: o3와 o4-mini의 성능을 평가하고, 이를 활용한 애플리케이션 개발을 고려합니다.

- 통합 모델 대비 준비: GPT-5 출시 전에 기능별 모델을 활용한 서비스 전략을 수립합니다.

💡 2. 구글, 'Gemini 2.5 Pro' 모델 무료 개방

📝 한 문장 요약

구글은 최신 AI 모델인 'Gemini 2.5 Pro'의 실험 버전을 모든 사용자에게 무료로 제공하며, 유료 구독자는 추가 기능을 이용할 수 있습니다.

📌 팩트체크

구글은 블로그를 통해 이러한 결정을 발표했습니다.

📌 사실 가능성 ★★★★★ (5/5)

구글의 공식 발표에 따른 조치로, 신뢰할 수 있습니다.

📌 기사 정확도 ★★★★★ (5/5)

공식 정보를 기반으로 한 정확한 보도입니다.

📌 앞으로 얻을 인사이트

- 무료 체험을 통한 유료 전환 전략: 구글은 무료로 최신 모델을 체험하게 함으로써 유료 구독을 유도하고 있습니다.

- 고급 기능의 차별화: 유료 구독자에게는 더 높은 사용 한도와 긴 컨텍스트 창 등 추가 기능이 제공됩니다.

📌 How-to 전략

- 무료 버전 활용: Gemini 2.5 Pro의 무료 버전을 활용하여 모델의 성능을 평가합니다.

- 유료 기능 고려: 추가 기능이 필요한 경우 유료 구독을 검토합니다.

🏭 3. 중국 AI 데이터센터의 과잉 투자와 유휴 상태 문제

중국의 AI 열풍으로 인해 데이터 센터가 비어 있고 GPU 임대료가 감소했습니다. 국가의 서둘러 건설된 데이터 센터 중 상당수는 추론 작업에 적합하지 않습니다.

참고기사

https://www.techspot.com/news/107325-china-ai-craze-has-led-empty-data-centers.html?utm_source=chatgpt.com

📝 한 문장 요약

중국에서 AI 열풍으로 수백 개의 데이터센터가 건설되었지만, 많은 시설이 활용되지 못하고 유휴 상태에 놓여 있습니다.

📌 팩트체크

- MIT 테크놀로지 리뷰의 보도:

📌 사실 가능성

- ★★★★★ (5/5)

📌 기사 정확도

- ★★★★★ (5/5)

📌 앞으로 얻을 인사이트

과잉 투자 위험성: 수요 예측 없이 인프라에 과도한 투자를 하면 자산이 유휴 상태에 빠질 수 있습니다.

기술 변화에 대한 대응 필요성: 빠르게 변화하는 기술 트렌드에 맞춰 인프라 투자를 신중하게 계획해야 합니다.

📌 How-to 전략

- 수요 기반 투자: 실제 수요를 기반으로 한 인프라 투자 전략을 수립합니다.

- 기술 트렌드 모니터링: 최신 기술 동향을 지속적으로 모니터링하여 투자 결정을 내립니다.

⚙️ 4. 엔비디아, FFN Fusion 기술로 추론 속도 향상

📝 한 문장 요약

엔비디아는 AI가 문장을 이해하고 처리하는 속도를 느리게 만드는 ‘순차 계산 병목’을 해결하기 위해, 여러 계산 단계를 병렬로 처리할 수 있게 하는 ‘FFN Fusion’ 기술을 개발했습니다. 이로 인해 추론 속도는 1.7배, 계산 비용은 최대 35배 줄어들었습니다.

📌 팩트체크

- ✅ FFN Fusion 관련 논문은 2025년 3월 24일, arXiv에 실제 게재되었으며, ‘라마 3.1’ 기반 모델에 적용해 성능 개선을 입증했습니다.

📌 사실 가능성

- ★★★★★ (5/5) 실제 실험 결과 수치를 바탕으로 하고 있으며, 병목 구간 개선은 AI 산업 내에서도 큰 이슈입니다.

📌 기사 정확도

- ★★★★★ (5/5) 핵심 기술 개념부터 벤치마크, 응용 가능성까지 명확히 정리되어 있습니다.

📌 앞으로 얻을 인사이트

- 모델 크기 경쟁 → 구조 최적화 경쟁으로 전환

- 실시간 대응, 모바일 AI, 경량 LLM 등 속도와 효율이 중요한 상황에서 FFN Fusion 기술은 필수 전략이 될 수 있음

- 기존 Transformer 구조도 리디자인 대상이 되는 흐름

📌 How-to 전략

- FFN Fusion 논문 요약 → 현업 적용 가능한 구조 파악

- 소형 또는 미드사이즈 LLM에서 병목 구간 테스트 후 구조 개편 고려

- 실시간 음성/비서/에이전트형 앱에서 속도 향상 시나리오 검토

🔗 출처

- 논문 원문:

- 논문 제목: "FFN Fusion: Efficient Transformer Inference via Feed-Forward Layer Fusion"

- 발표일: 2025년 3월 24일

- 주요 벤치마크: MMLU, HumanEval, Arena Hard 등에서 기존 모델 대비 동등하거나 더 우수한 결과 기록

⚠️ 5. AI를 너무 많이 훈련시키면 오히려 성능이 떨어질 수 있다?

📝 한 문장 요약

“데이터가 많을수록 좋다”는 기존 AI 학습 방식에 경고등이 켜졌습니다. 사전 학습을 너무 많이 하면, 이후 특정 작업에 맞춰 조정할 때 성능이 떨어지는 ‘과잉 훈련 재앙(Catastrophic Overtraining)’이 발생할 수 있다는 연구가 발표됐습니다.

📌 팩트체크

- ✅ 카네기멜론대, 스탠포드, 하버드 등 연구진이 2025년 3월 28일, arXiv에 실제 논문 발표

- ✅ Open-source LLM ‘OLMo-1B’를 대상으로 직접 실험 수행

📌 사실 가능성

- ★★★★☆ (4.5/5) 사전 학습량과 미세 조정 결과 간의 민감도 차이는 현업에서도 지속적으로 제기되는 이슈

📌 기사 정확도

- ★★★★☆ (4.5/5) 실험 기반 내용은 신뢰도 높지만, 일부 한정된 모델 기준이라는 점은 감안해야 함

📌 앞으로 얻을 인사이트

- 이제는 데이터 양보다 “적정 학습량”과 “안정적 튜닝 가능성”이 더 중요한 요소로 부상

- 스케일링 법칙의 한계를 넘어, 유연한 학습 설계로 넘어가야 할 시점

- AI가 너무 많이 배워서, 새롭게 배우는 걸 오히려 잊는다는 개념은 실무에 큰 시사점을 줌

📌 How-to 전략

- 내부 LLM 학습 전략 → 임계값 설정, 튜닝 민감도 모니터링 도구 도입

- Instruction Tuning 시, 과잉 학습 여부에 따른 성능 변화 실험 설계

- 향후 RLHF, RAG 등 사전 학습을 보완하는 전략적 학습 구조 적용

🔗 출처

- 논문 원문: https://arxiv.org/abs/2503.18939

- 논문 제목: "Catastrophic Overtraining in Large Language Models"

- 발표일: 2025년 3월 28일

- 실험 모델: OLMo-1B, 2.3조 vs 3조 토큰 학습 모델 비교

- 핵심 발견: 3조 토큰 이상 학습 모델은 instruction tuning 성능이 평균 2~3% 낮음

최종 인사이트

“2025년 이후의 AI는 크기보다 _지능적인 구조와 균형 있는 설계_가 핵심이 된다.도입 전략은 ‘빠르게 만들고, 작게 시작하고, 현명하게 확장하라’가 정답이다.”

✅ 활용 전략 (One-Liner Version)

빠른 피드백 → 소형 모델부터 실험하고

실사용 기반 → 무료·오픈 리소스로 시작하고

예산 대비 → 수요와 구조를 기준 삼고

튜닝 전략 → 균형 잡힌 학습을 설계하고

실시간 서비스 → 속도 최적화를 고려하라

“2025년 이후의 AI는 크기보다 _지능적인 구조와 균형 있는 설계_가 핵심이 된다.도입 전략은 ‘빠르게 만들고, 작게 시작하고, 현명하게 확장하라’가 정답이다.”

* 위의 내용은 AI 타임즈를 참고하여 작성하였습니다.

각 내용의 출처도 참고해주시기 바랍니다.

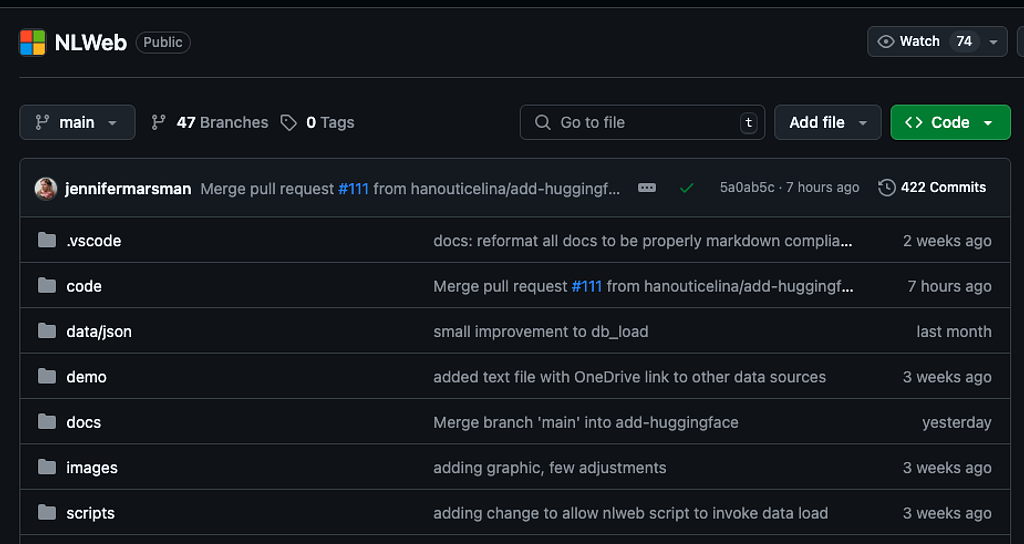

생성형 aI로 만들어진 앱들의 다양한 피드백을 받습니다.

피드백과 보완을 통해서 더 획기적인 방식의 디벨롭이 가능하니

참여와 댓글 부탁드립니다.

궁금해요! AB test에 참여해주세요.

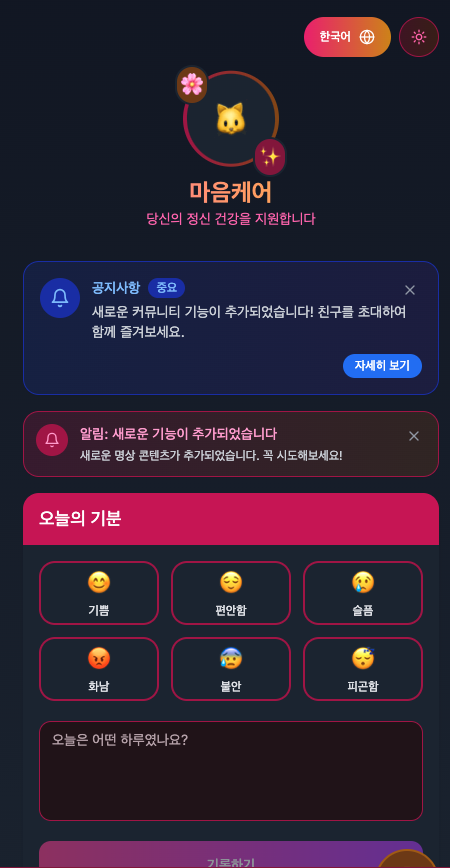

🌿 하나의 마음케어 앱, 두 가지 샘플링

🌿두 가지 샘플링으로 하나의 마음케어 앱을 만들어봤어요!같은 목표를 가지고 있지만, 각 샘플링은 다른 방식으로 접근해봤어요!

프로토 타입으로 AB 테스트를 진행해봅니다.

샘플링1: 직관적 디자인으로 빠르게 마음을 다스리기

샘플링2: 실시간 피드백과 맞춤형 조언으로 웰니스 유도

어떤 샘플이 더 마음에 드시나요?여러분의 피드백은 큰 힘이됩니다 😍💬

1つのマインドケアアプリ、2つのサンプリング🌿。

二つのサンプリングで一つのマインドケアアプリを作ってみました!

同じ目標を持っていますが、それぞれのサンプリングは異なる方法でアプローチしています。サンプリング1: 直感的なデザインで素早く心を整える サンプリング

2: リアルタイムのフィードバックとパーソナライズされたアドバイスで自己啓発を促します。

どちらのサンプルが好きですか?

皆様のフィードバックをお待ちしています! 💬💬💬💬。

number 1

number2

이 뉴스레터의 모든 콘텐츠(텍스트, 이미지, 디자인 등)는 저작권법의 보호를 받으며, flux를 이용한 AI 아트를 창작물 입니다.

뉴스레터 발행자의 승인 없이 무단 복제, 배포, 수정, 전재, 또는 상업적 이용을 금합니다.개인적인 참고나 공유를 위해 사용하실 경우, 원본 링크를 명확히 표시해 주시기 바랍니다.

Copyright NoticeAll content in this newsletter (text, images, design, etc.) is protected under copyright law. Unauthorized reproduction, distribution, modification, retransmission, or commercial use without the publisher's consent is strictly prohibited.For personal reference or sharing, please clearly attribute the original source.

의견을 남겨주세요

bros

비공개 댓글 입니다. (메일러와 댓글을 남긴이만 볼 수 있어요)

의견을 남겨주세요

cc

비공개 댓글 입니다. (메일러와 댓글을 남긴이만 볼 수 있어요)

의견을 남겨주세요