1. 들어가며: 트래킹과 모션캡쳐

최근 국내에서 버튜버에 대한 관심이 폭발적으로 늘어나면서, '어떻게 버튜버가 되지?' '저 버튜버는 어떻게 저렇게 움직이는 거지?' 하는 질문을 자주 접하게 됩니다.

사실 저는 버튜버를 직접 해본 적도, 버튜버 제작사나 관련 기업에서 일해본 적도 없지만, 개인적인 호기심에서 시작한 리서치를 통해 알게 된 내용을 공유해보려 합니다.

버튜버의 구현 방식은 크게 '트래킹'과 '모션캡처'로 나눌 수 있는데요. 트래킹은 쉽게 말해서 사람이나 물체의 위치를 실시간으로 따라가는 기술입니다. VR 기기가 머리나 손목의 움직임을 감지하거나, 스마트폰이 GPS로 위치를 찾는 것과 유사합니다.

반면 모션캡처는 좀 더 복잡하고 정교한 기술입니다. 사람의 전체적인 움직임을 세세하게 기록하는 거죠. 특히 관절이나 신체 부위의 미세한 움직임까지 한 번에 캡처할 수 있어서, 영화나 게임 제작에서 실제 배우의 동작을 캐릭터에 자연스럽게 입히는 데 사용됩니다. 다만 추가로 특수 장비나 센서가 필요해서, 움직임에 대한 데이터를 더 자세히 얻을 수 있는 만큼 비용도 많이 들어갑니다.

정리하자면, 트래킹이 '어디에 있는지'를 쫓는 기술이라면, 모션캡처는 '어떻게 움직이는지'까지 꼼꼼하게 기록하는, 더 포괄적인 형태라고 볼 수 있습니다.

버튜버들은 콘텐츠의 종류, 그리고 (가장 중요한) 예산에 따라 이 두 가지 기술을 적절히 활용하는데요. 모션캡처가 좀 더 폭넓은 개념이다 보니, 본 콘텐츠에서는 버튜버들의 모션캡처 활용을 중심으로 이야기를 해보려고 합니다.

2. 모션캡쳐 구현 방식에 따른 구분

기본적으로 모션캡쳐는 사람과 물체의 움직임을 디지털 데이터로 기록하고 재현하는 기술입니다. 이 기술은 센서나 카메라를 사용하여 사람과 물체의 움직임을 감지하고, 이를 컴퓨터로 전송하여 디지털화하는데요.

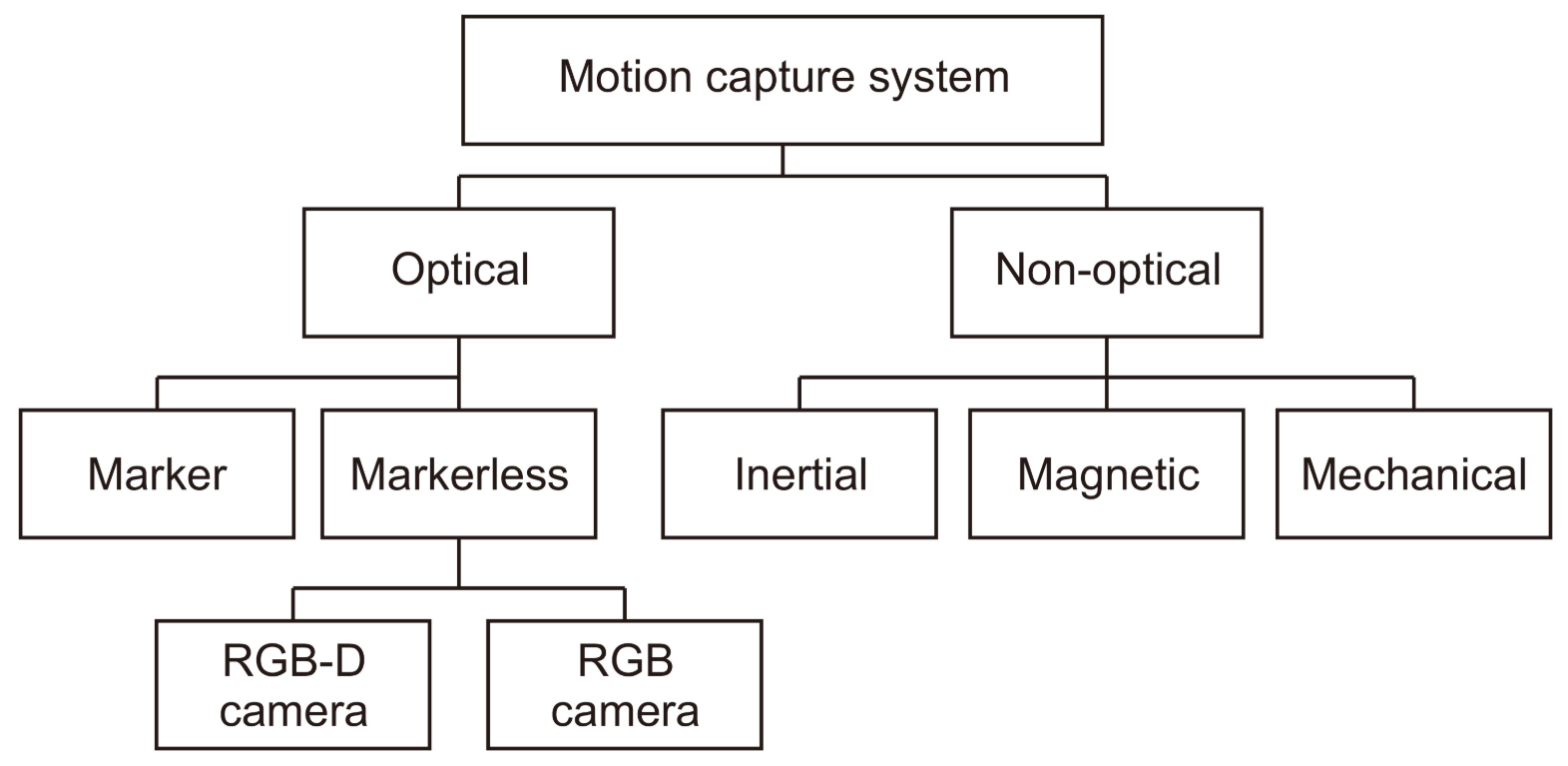

주로 인체의 관절과 근육의 미세한 움직임을 추적하여 3D 모델에 적용하는 방식으로 작동합니다. 모션캡쳐 기술은 특정 기기를 착용하거나, 몸에 센서를 부착하나, 적외선이나 AI를 이용하는 등의 방법 등 구현 방식에 따라 구분이 가능합니다.

사전적으로 분류하면 위와 같지만, 현재 많이 사용되고 알려져 있는 관성식(Inertial), 광학식(Optical)과 마커리스(Markerless)에 대한 내용 위주로 소개해 보겠습니다.

2.1 관성식 모션캡쳐

먼저 관성식 모션캡쳐는 기울기와 가속도, 지구자기장을 측정하는 센서가 신체의 관절 및 주요 부위에 부착된 전용 수트로 모델의 움직임과 회전, 방향을 읽어내는 방식입니다.

관성식 모션캡쳐의 핵심은 바로 IMU라고 불리는 관성측정장치입니다. 이 작은 센서들은 우리가 스마트폰을 돌렸을 때 화면이 회전하는 것과 비슷한 원리로 작동하는데, 훨씬 더 정교하고 정확한 측정이 가능하죠.

실제 모델은 센서가 부착된 수트를 입고 움직이게 되는데, 각각의 센서들은 마치 작은 나침반처럼 방향과 움직임을 감지하며 이 정보를 실시간으로 컴퓨터에 전송합니다.

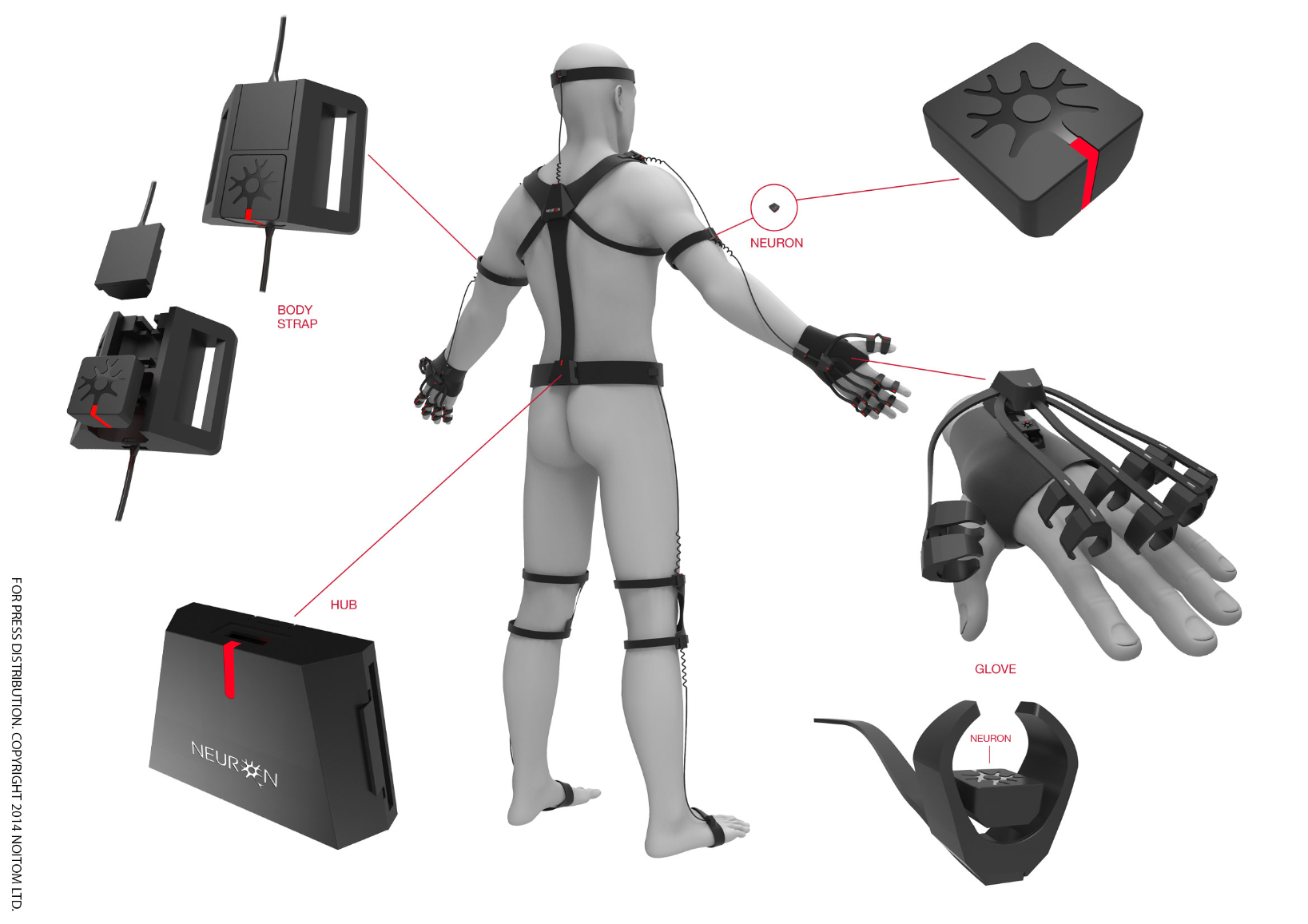

가성비 모션캡쳐 장비로 알려져 있는 퍼셉션 뉴런(Perception Neuron)도 관성식입니다. 기본적으로 몸에 착용하는 스트랩과 장갑이 있으며, 이 장갑과 스트랩에 센서를 부착하는 형태로 되어있습니다.

센서를 각 관절 부위에 부착하여 센서의 움직임을 통해 사용자의 움직임을 렌더링 한 후 3D 화면으로 뿌려주고, 전용 소프트웨어를 통해 실시간으로 센서의 위치변화를 감지하며, 캡처 이후 후보정까지 진행하게 됩니다.

관성식 모션캡쳐의 가장 큰 장점은 상대적으로 높은 자유도에 있습니다. 예를 들어, 영화나 게임 제작 현장에서 야외 촬영을 해야 하는 경우, 다른 모션캡쳐 방식들은 환경적 제약으로 인해 사용이 어려울 수 있지만, 관성식은 날씨나 장소에 크게 구애받지 않을 수 있습니다.

또한 관성식 모션캡쳐는 경제적인 측면에서도 상대적으로 장점이 있습니다. 후술할 광학식 모션캡쳐가 대규모 스튜디오와 고가의 장비를 필요로 하는 것과 달리, 관성식 은 상대적으로 적은 비용으로도 모션캡쳐가 가능합니다.

![[분석] 뉴로사마와 AI 코요리, 라디안과 루나로 알아보는 AI 버튜버의 현재와 미래의 썸네일 이미지](https://cdn.maily.so/bwkvl4spapt243jayhowvis82hfk)

![[번역] 가트너: 2025년 주목할 10대 전략 기술 트렌드의 썸네일 이미지](https://cdn.maily.so/7j6v6fi4e47bxs31by44557in4ee)

의견을 남겨주세요