안녕하세요:) 이번주에도 찾아온 BDA 뉴스레터입니다!

5월은 대학 축제 등 특별한 행사가 많은 달이기도 합니다. 학회원 분들도 즐거운 5월을 보내고 계신가요?

이번주 뉴스레터에서도 학회 내 소식은 물론이고, 저번주 부터 시리즈로 연결되는

'Attention Is All You Need를 읽기 위한 준비 — RNN에서 Transformer까지' 데이터 트렌드 이슈의 2번째 내용을 살펴보실 수 있습니다! 총 5회차가 연재되니 꼭 끝까지 읽어주세요 :)

5월 3주차 BDA NEWS 🗞️

데이터 트렌드 이슈

현재 핫한 데이터 이슈를 소개하고자 합니다‼

데이터 관련 직무를 꿈꾸고 있는 당신이라면 꼭 확인해야 하는 필수 정보이니 놓치지말고 얻어가세요🤎

각 트렌드 이슈에 자세한 내용이 알고 싶다면 밑의 버튼을 눌러보세요🚀

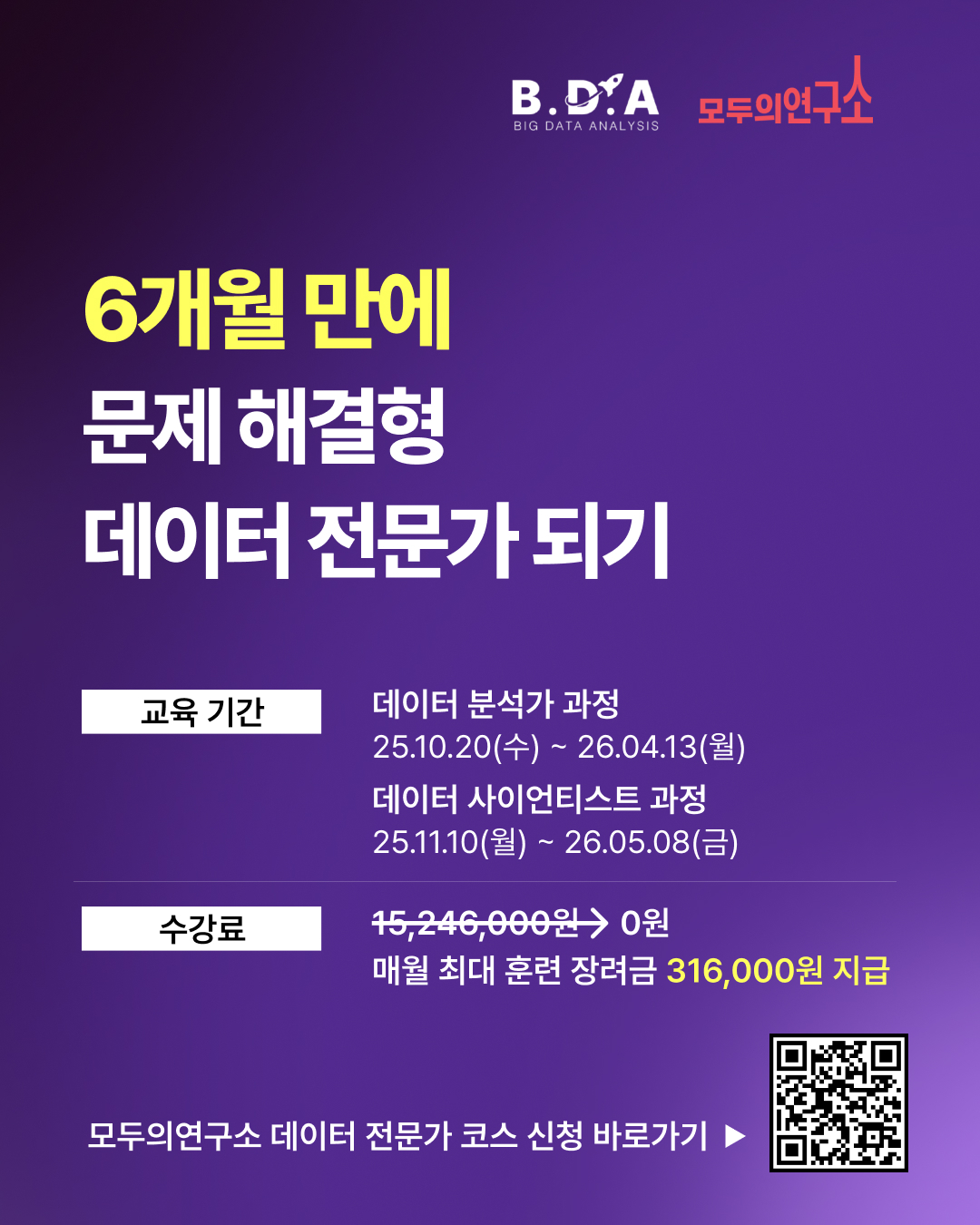

데이콘 협업 안내

학회원들의 데이터 분석 역량 증진을 위해 데이콘과 협업하여 최종 과제를 출제합니다 🤗

자세한 내용은 아래의 버튼을 눌러 확인해보세요 🚀

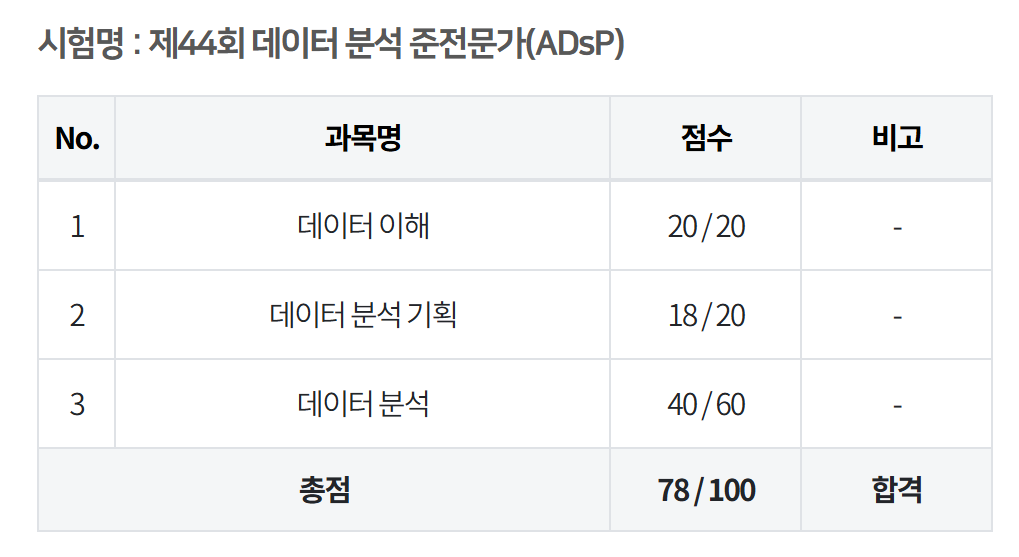

빅데이터분석기사 실기 스터디 모집

B.D.A에서 학회원분들의 스펙 쌓기를 돕고자 영진닷컴과 함께 빅데이터 분석기사 실기 자격증 대비 스터디를 모집합니다🎉

스터디에 관한 자세한 일정은 밑의 링크를 통해 확인해보세요 🤎

5월 3주차 DATA 트렌드 인사이트 🧐

Attention Is All You Need를 읽기 위한 준비 — RNN에서 Transformer까지 (2/5)

LSTM (Long Short-Term Memory)의 구조와 개선된 점

LSTM이란 무엇인가요?

LSTM(Long Short-Term Memory)은 기존 RNN이 가지고 있던 한계, 특히 기울기 소실(Gradient Vanishing) 문제를 해결하기 위해 등장한 구조입니다.

> RNN은 오래된 정보일수록 기억하기 어려웠지만, LSTM은중요한 정보를 장기적으로 기억

텍스트, 시계열, 음성 등 순차적인 데이터를 다룰 때 강력한 성능을 발휘하며, 이후 많은 딥러닝 구조의 핵심이 되었습니다.

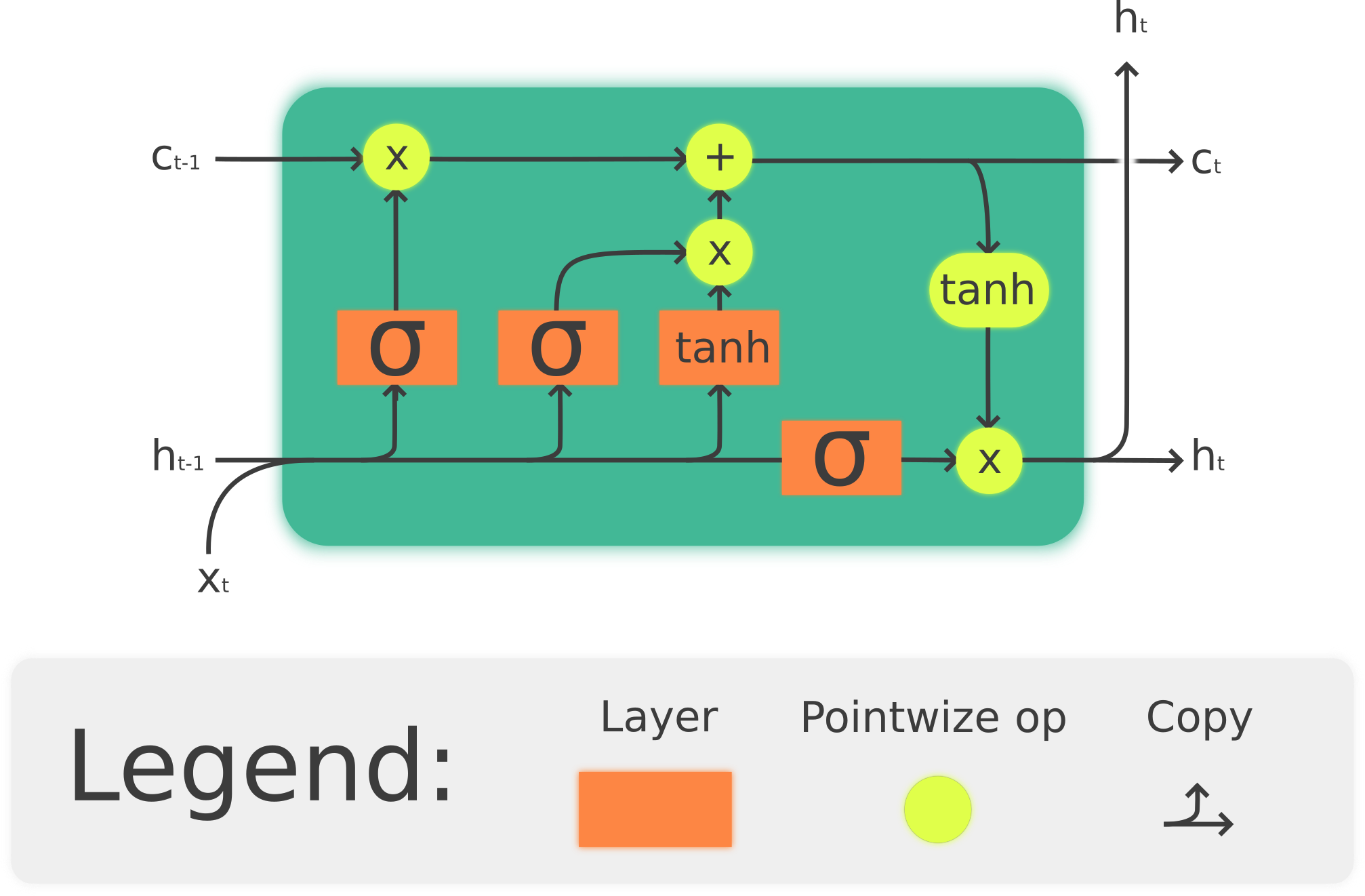

LSTM의 구조

LSTM은 정보의 흐름을 정교하게 제어하기 위해 ‘게이트(Gate)’라는 구조를 사용합니다. 이 게이트들은 어떤 정보를 기억하고, 어떤 정보를 버릴지 결정합니다.

🔹 Cell State (셀 상태)

- 셀의 중심을 가로지르는 굵은 선

- 이전 시점의 정보를 장기적으로 보존하거나, 필요 시 잊을 수 있는 메모리 저장소

🔹 Forget Gate (망각 게이트)

- 셀 상태에서 어떤 정보를 지울지 결정

- 과거의 정보 중 중요하지 않은 것을 제거함

🔹 Input Gate (입력 게이트)

- 새로운 정보 중 어떤 것을 기억할지 결정

- 현재 입력을 기반으로 셀 상태를 업데이트

🔹 Output Gate (출력 게이트)

- 현재 시점에서 어떤 정보를 출력으로 보낼지 결정

- 다음 단계로 전달할 hidden state를 생성

왜 RNN보다 LSTM이 좋은가요?

| 구분 | RNN | LSTM |

|---|---|---|

| 기억 유지 | 오래된 정보 소실 | 장기 정보 유지 가능 |

| 학습 안정성 | 기울기 소실로 학습 어려움 | 게이트 메커니즘으로 안정적인 학습 |

| 활용도 | 단순 시퀀스 | 복잡한 의존 구조까지 대응 가능 |

LSTM이 활약하는 분야

- 🗣 기계 번역 (Machine Translation)문맥을 유지하면서 더 자연스러운 번역을 구현

- 🎙 음성 인식 (Speech Recognition)사람 말투의 흐름과 억양을 이해하는 데 강점

- 📈 주가 예측 (Stock Prediction)시계열 데이터의 추세와 패턴을 학습하여 미래 예측

- 📝 텍스트 요약 (Text Summarization)문서의 핵심을 파악해 간결한 문장으로 요약

💡 다음 뉴스레터 예고:

“Seq2Seq: 기계 번역의 새로운 시대를 열다”

Seq2Seq 모델이 어떻게 Encoder-Decoder 구조로 언어를 번역하는지 설명합니다.

[출처 및 참고]

- What is LSTM – Long Short Term Memory? - GeeksforGeeks

- Understanding LSTM Networks - Colah’s Blog

작성: 6기 서베이팀 박찬규, 신미수, 양지호

의견을 남겨주세요