AI가 단순히 콘텐츠를 생성하는 것을 넘어 직접 구현할 때 어떤 일이 벌어질까요? AI는 이미 실제같은 사진, 영상, 목소리 생성 능력을 완벽히 익혀 시각적, 청각적 튜링 테스트를 통과했습니다. 앞으로의 큰 도약은 AI 아바타 분야입니다. 바로 얼굴과 목소리를 합쳐 말하는 캐릭터를 만드는 것이죠.

얼굴 이미지를 만들고, 움직이게 한 다음 목소리를 입히면 되지 않을까요? 그렇게 간단하지 않습니다. 진짜 어려운 점은 입 모양을 맞추는 것뿐만 아니라 얼굴 표정과 몸짓이 함께 자연스럽게 움직이게 하는 것입니다. 놀라서 입이 벌어졌는데 뺨과 턱이 전혀 움직이지 않는다면 어색하겠죠! 또 목소리는 신나게 들리는데 얼굴은 반응이 없다면, 사람 같다는 느낌이 완전히 깨져버립니다.

이 분야에서 눈에 띄는 발전이 이루어지고 있습니다. AI 아바타는 이미 콘텐츠 제작, 광고, 기업 소통에 활용되고 있어요. 현재 모델들은 대부분 말하는 얼굴 부분에만 집중되어 있습니다. 기능은 있지만 아직 한계가 있죠. 그래도 최근 몇 달 사이에 흥미로운 발전들이 있었고, 곧 의미 있는 진보가 이루어질 것이 분명해 보입니다.

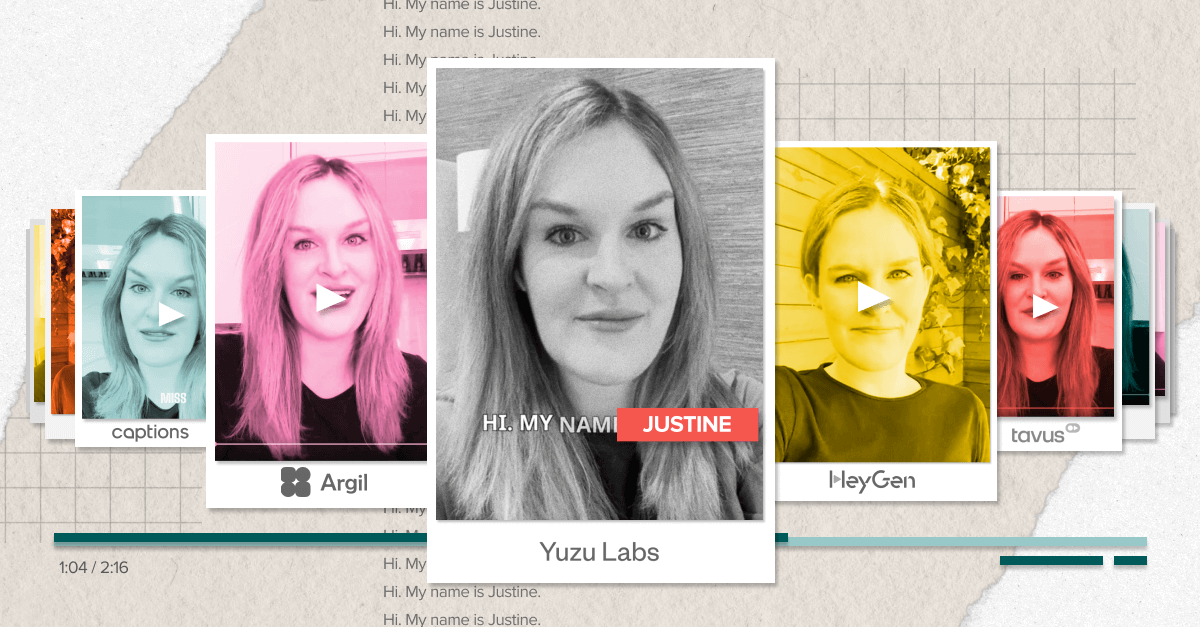

이 글에서는 현재 제대로 작동하는 기술, 앞으로 나올 기술, 그리고 제가 20개가 넘는 제품을 직접 테스트한 결과를 바탕으로 오늘날 가장 인상적인 AI 아바타 제품들을 살펴보겠습니다.

연구는 어떻게 진화해왔을까요?

AI 아바타는 일반적인 AI 연구보다 훨씬 복잡한 과제를 안고 있습니다. 말하는 얼굴을 만들기 위해 모델은 음성 소리(음소)와 그에 맞는 입 움직임(시소리) 사이의 관계를 사실적으로 배워야 합니다. 이 관계가 "어긋나면" 입과 목소리가 따로 놀거나 완전히 어색해 보이게 됩니다.

문제가 더 복잡해지는 이유는 말할 때 입만 움직이는 게 아니라는 점입니다. 얼굴의 다른 부분들도 함께 움직이고, 상체와 때로는 손까지도 움직이죠. 또한 모든 사람은 자기만의 독특한 말하기 방식을 가지고 있습니다. 여러분이 좋아하는 연예인과 비교해 여러분이 어떻게 말하는지 생각해보세요. 같은 문장을 말하더라도 입 움직임이 다를 겁니다. 여러분의 말하는 방식을 그들 얼굴에 적용하면 어색해 보일 거예요.

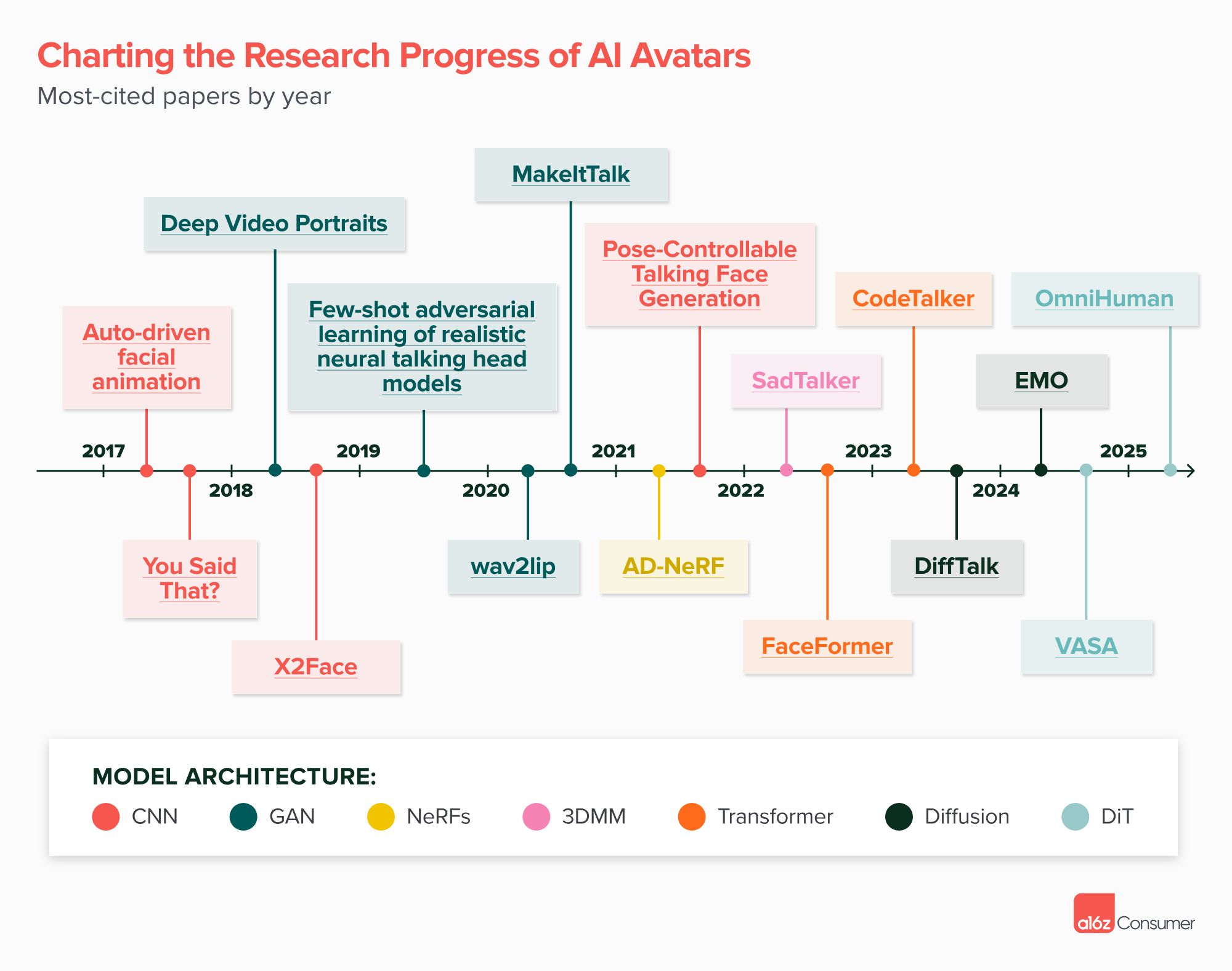

지난 몇 년간 이 분야는 연구 측면에서 크게 발전했습니다. 제가 2017년 이후 AI 토킹 헤드 관련 논문 70개 이상을 검토한 결과, 모델 구조에서 뚜렷한 발전 흐름을 발견했습니다. CNN과 GAN에서 시작해 NeRF와 3D 가변 모델 같은 3D 기반 접근법으로, 그 다음엔 트랜스포머와 디퓨전 모델로, 그리고 최근에는 DiT(트랜스포머 구조 기반 디퓨전 모델)로 진화했죠. 아래 타임라인은 각 연도별 가장 많이 인용된 논문들을 보여줍니다.

생성물의 품질과 모델 기능 모두 놀라울 정도로 좋아졌습니다. 초기 방식은 매우 제한적이었어요. 한 사람의 사진 한 장으로 시작해 얼굴 아래쪽 절반을 가리고, 음성 입력에서 얻은 얼굴 특징점을 기반으로 새로운 입 움직임을 만드는 정도였습니다. 이런 모델들은 제한된 양의 고품질 립싱크 데이터로 훈련됐으며, 대부분 얼굴 부분만 클로즈업된 영상이었죠. "오바마 립싱크" 같은 더 현실적인 결과물은 대상 인물의 수많은 영상 시간이 필요했고, 결과물도 매우 제한적이었습니다.

오늘날의 모델들은 훨씬 더 유연하고 강력해졌습니다. 이들은 상체나 전신 움직임, 실감나는 말하는 얼굴, 그리고 역동적인 배경 움직임까지 모두 한 영상에서 만들어낼 수 있어요! 이런 최신 모델들은 훨씬 더 큰 데이터셋에서 기존 텍스트-투-비디오 모델처럼 훈련됐으며, 다양한 움직임 속에서도 립싱크 정확도를 유지하기 위한 여러 기술을 활용합니다.

이에 대한 첫 선보임은 2월에 공개된 바이트댄스의 옴니휴먼-1(OmniHuman-1) 모델이었습니다(최근 드리미나에서 사용 가능해졌어요). 이 분야는 빠르게 발전하고 있어요 - 헤드라(Hedra)는 3월에 캐릭터-3(Character-3)를 출시했는데, 이는 저희의 일대일 테스트에서 대부분의 사용 사례에서 최고 수준으로 평가됐습니다. 헤드라는 이 말하는 웨이모 같은 비인간 캐릭터에도 잘 작동하며, 사용자가 텍스트로 감정과 움직임을 지시할 수 있게 해줍니다.

![[번역] "러브 라이브!" 경제 효과가 정말로 대단한 이유, 오타쿠를 총동원시킨 "장치"의 비밀의 썸네일 이미지](https://cdn.maily.so/qxcs8elbjm3t7h2yrbyszw2q4agq)

![[번역] 매튜 볼: 로블록스는 이미 세계에서 가장 큰 게임인데, 왜 수익을 못 낼까? 어떻게 하면 수익화할 수 있을까?의 썸네일 이미지](https://cdn.maily.so/l6zqd3a3t70aieycbb923x9iyypd)

![[분석] 그록 4의 AI 컴패니언 모드, AI 캐릭터 챗봇 애니(Ani) 리뷰의 썸네일 이미지](https://cdn.maily.so/7bij2t3hxycr6gpsftw4s883lc2g)

![[번역] AI 캐릭터 기업 픽토리아(Pictoria), 격동의 2024년을 돌아보며 25년 전망을 이야기하다의 썸네일 이미지](https://cdn.maily.so/cj5ebilf8yu1fyai2iyz723pm0ch)

![[번역] 나 자신의 AI 아바타와 함께한 1년: AI 정체성과 아바타 경제 최전선 현장 보고서의 썸네일 이미지](https://cdn.maily.so/ethb493dupexz92vr6cmvtcisq40)

의견을 남겨주세요