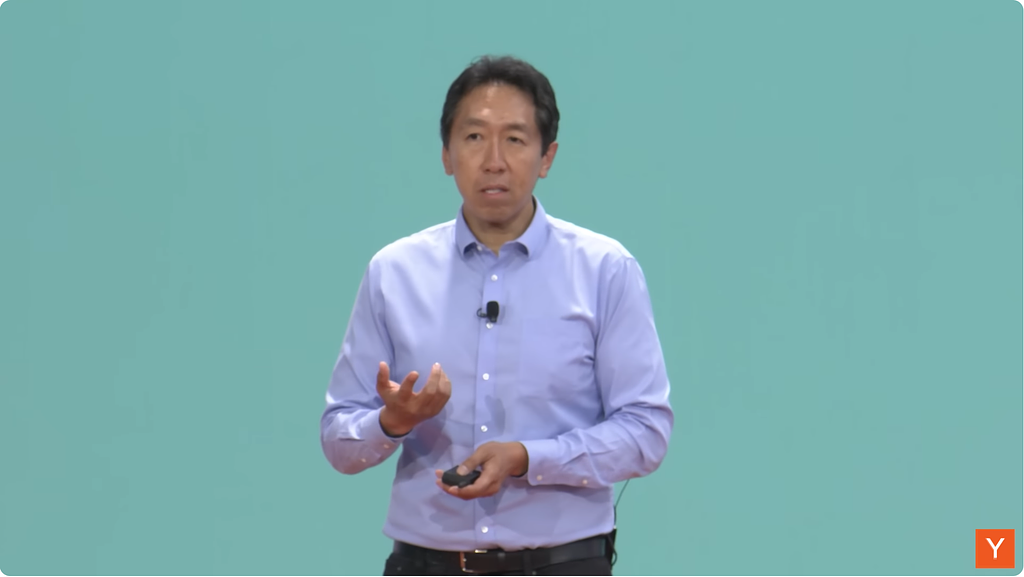

전 OpenAI 창립멤버이자 Tesla 인공지능부서 디렉터를 역임한 안드레이 카파시가 팟캐스트 채널 No Priors과 진행하여 2024년 9월 5일 공개된 인터뷰 내용을 리뷰해봤습니다.

자율주행 기술 현황

- 웨이모와 테슬라가 선두를 다투고 있음

- 웨이모는 현재 샌프란시스코에서 상용 서비스 중

- 테슬라가 푸는 문제는 소프트웨어적인 문제고 웨이모가 푸는 문제는 하드웨어적인 문제

- 소프트웨어적인 문제가 훨씬 풀기 쉽고, 테슬라는 이미 규모에서 웨이모와 비교가 안됨

- 카파시는 10년 내 테슬라가 우위를 점할 것으로 전망

AI 모델 발전 방향

- 트랜스포머 모델이 AI 연구의 핵심

- 인터넷에서 찾을 수 있는 데이터는 이미 다 학습해버려서 현재는 데이터셋과 loss function 최적화에 초점

- 인터넷에서 찾을 수 있는 데이터는 사실 인간 사고의 결과물, 지금 부족한 데이터는 인간의 머릿속에서 여러 단계로 일어나는 사고 과정에 관한 것

- 트랜스포머 모델로 사고 과정을 역으로 만들어가는 합성 데이터 생성이 중요해질 것으로 예상

- 1억 개 미만의 파라미터로도 강력한 AI 모델 구현이 가능해질 것 (GPT4 1조8천억 개 파라미터로 추정)

AI와 인간의 융합

- AI를 외부 대뇌피질로 활용 가능

- 장기적으로 AI와 인간의 경계가 모호해질 것

- 개인화된 AI 비서나 도구 형태로 발전 예상

AI 교육 플랫폼 (Eureka Labs)

- 카파시가 개발 중인 AI 기반 교육 플랫폼

- AI를 활용해 개인화된 학습 경험 제공 목표

- 2024년 초 출시 예정, 첫 강의는 LLM101n (https://github.com/karpathy/LLM101n)

- 대학생 수준의 기술 교육에 초점

리뷰

안드레이 카파시는 업계에서 천재로 손꼽히는 인물 중의 하나로, 테슬라 인공지능팀에서 자율주행 관련 연구를 하다가, OpenAI에는 창립멤버로 조인하고 지금은 스탠포드에서 강의도 하는 인물입니다. 나이는 1986년으로 아직 37살밖에 되지 않았죠.

인터뷰 내용을 보면 Bottleneck, 즉 병목이라는 표현이 등장하는데요, 트랜스포머 모델의 등장으로 인해 그동안의 병목이었던 모델 문제가 해결되었다고 이야기를 해주고 있습니다. 앞으로의 병목은 데이터 부족과 loss 함수에 대한 것이라고 이야기를 하는데요.

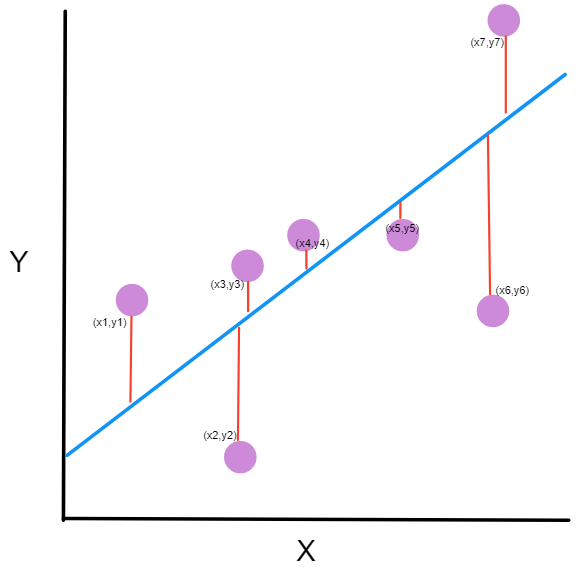

loss 함수는 말 그대로 우리가 원하는 결과값과 모델의 출력값 사이의 loss를 계산하는 함수인데요, 과거에는 Mean Square Error(MSE) 같은 함수가 쓰이다가 LLM 시대에 들어와서는 Cross-Entropy Loss 또는 Negative Log-Likelihood 함수가 자주 쓰인다고 합니다.

Loss 함수는 모델의 학습에 필수적인 요소인데, 이제 모델에서의 문제는 풀렸으니 앞으로는 이 분야에서 발전할 여지가 많다는 이야기로 들렸고요, 더욱 흥미로운 부분은 인간의 사고과정에 대한 데이터가 부족하다는 언급이었습니다.

이미 인터넷 데이터를 통해 인간 사고의 "결과물"에 대한 데이터는 상당히 확보를 했는데 이런 데이터들이 어떤 과정을 거쳐 만들어졌는지, 그러니까 유튜브 비디오를 예로 들자면, 한편의 영상을 만들기 위해 기획회의, 대본, 촬영 등 많은 과정들이 있었을텐데, 그 모든 과정을 스킵하고 결과물만을 가지고 학습한 모델이 비슷한 결과물을 만들기는 어렵다는 것입니다.

인공지능이 비슷한 결과물을 만들기 위해서는 그 결과물이 나오기까지의 과정에 대한 데이터도 필요하다는 이야기인데요, 현재의 학습데이터에는 그 부분이 빠져있다는 이야기죠. 그런데 이런 데이터를 인간이 만들기에는 비용이나 시간의 문제가 있을 겁니다.

그래서 나온 이야기가 "합성데이터". 즉, 이 과정을 LLM을 통해 인공적으로 생성해보자는 것이고요, 합성 데이터의 안전성을 담보해야 하니 거기에 대해서는 주의를 해야겠다는 인사이트도 언급하고 있습니다.

최근에 출신된 OpenAI의 o1모델의 경우도 바로 이 부분을 보강한 것으로 보여지는데 이제부터는 바로 이 합성데이터를 어떻게 잘 활용하느냐가 관전 포인트가 될 것 같습니다.

의견을 남겨주세요