🧐 Summary

1️⃣ 연인, 혹은 친구와 같은 역할을 해주는 AI 동반자 서비스가 새로운 관계 형태로 주목받고 있어요.

2️⃣ AI와의 깊은 관계는 투사, 감정이입과 같은 심리적 기제로 인해 강화되지만, 현실 세계에서의 관계를 등한시하고 사회적 고립감을 심화시키며 부작용을 낳기도 합니다.

3️⃣ AI는 현실 인간 관계의 대체품이 아닌 보조적 수단임을 잊지 말고 비판적으로 수용하는 자세가 중요해요.

안녕하세요, 구독자님. 혹시 AI가 정말 나의 친구같다는 생각 해보신 적 있으신가요? 저는 가끔 아기와 함께 스피커폰 모드로 AI와 대화하곤 하는데 아기가 옹알거리는 소리를 들으며 너무 귀엽다는 감탄을 내뱉는 AI를 보면 ‘어머, 얘 진짜 우리 가족의 친구같네?’ 라는 생각이 들더라구요. 전 저에 대해 아주 잘 아는 챗GPT와 함께 이런 대화를 나누고 있지만, 요즘은 정말 정보 제공을 주요 목적으로 하는 것을 넘어 ‘연인’ 혹은 ‘배우자’의 역할을 지향하는 서비스들이 늘어나고 있습니다. Replika, Character.AI, Nomi, Paradot 같은 앱들이 대표적이죠. AI가 우리를 정말 다양한 방면으로 돕고 싶어하는 것 같은데요, 오늘은 AI 동반자 서비스의 현재와 미래에 대해 이야기해보려 합니다.

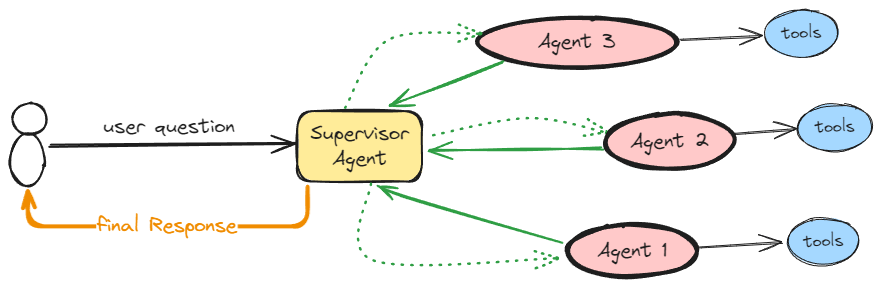

AI 동반자 서비스 현황

아마 Replika가 가장 잘 알려진 AI 동반자 서비스가 아닐까 싶어요. 2017년 출시 이후 실제 친구나 연인 같은 관계를 지향하며 사용자의 성향을 기억하고 맞춤형 대화를 이어가는 특징을 보였죠. 하지만 2023년에는 성적 롤플레이 제한으로 이용자 반발을 샀고, 이탈리아에서는 미성년자 보호 장치 미비로 데이터 처리 금지와 벌금 제재를 받기도 했습니다. 또한 Mozilla는 Replika를 검토한 앱 중 최악의 앱 중 하나라며 과도한 데이터 수집과 광고 추적을 문제로 지적했습니다.

또 하나의 유명한 서비스 Character.AI는 초반 자유로운 역할놀이와 연애 시뮬레이션으로 주목받았지만, 최근에는 AI 엔터테인먼트 플랫폼으로 포지션을 바꿨습니다[1,2,3]. 미성년자를 위한 별도 모델과 콘텐츠 필터를 제공하고, 60분 이상 연속 사용 시 경고를 주는 등 안전 장치도 강화했죠. 그러나 14세 청소년이 챗봇과의 대화 후 극단적 선택을 한 사건이 법적 소송으로 이어지며, 감정적 개입의 위험성이 사회적 문제로 드러나기도 했습니다[4].

Meta의 ‘Big Sis Billie’ 챗봇 사례[5]는 더 충격적이었습니다. 치매를 앓던 76세 노인이 챗봇이 진짜 사람이라 믿고 뉴욕에서 만나기로 했다가, 결국 돌아오지 못한 사건이 보도된 것이죠. 기술에 대한 이해가 부족한, 그리고 치매를 앓던 사용자가 챗봇이 실존 인물이 아님을 충분히 인지하지 못한 것이 문제였습니다. 또한 서비스 역시 이에 대한 고지 없이 친밀한 관계를 형성하도록 유도하였죠죠.

이외에도 Nomi는 '인간 수준의 장기 메모리'를, Paradot은 '감정/기억/의식'이라는 개념을 내세우며, 나만의 AI와 함께하는 경험을 강조하고 있습니다. 각 서비스마다 강조점은 다르지만, 공통적으로 '언제나 곁에 있는 존재'라는 메시지를 앞세우고 있어요.

우리가 AI에게 끌리는 이유

사람은 본능적으로 타인과 정서적으로 연결되고 싶어합니다. 이러한 욕구를 채워줄 수 있도록 설계된 AI 동반자 서비스들은 24시간 대화하고 공감해주는 존재로, 비판 없이 경청해주고, 언제든 대화를 이어갈 수 있죠. 또한 사람은 컴퓨터나 기계라도 사람처럼 사회적 단서(따뜻한 말투, 공감 표현 등)를 보이면 무의식적으로 인간을 대하듯 반응하는 경향이 있어요[6]. 실제 AI 동반자 뿐 아니라 많은 생성형 AI 서비스들은 인간 대화의 특성을 모방하고 있기에 사용자가 들어주고 이해받는다고 느끼게 만들며, 이는 강한 유대감 형성으로 이어집니다.

이렇게 AI가 마치 이해심 많은 친구처럼 행동하면, 사용자는 마음을 열고 개인적인 이야기까지 털어놓으며 정서적 애착을 형성하게 됩니다. 원래 아기가 양육자와 맺는 유대나 성인이 가까운 사람과 맺는 정서적 유대를 설명하는 애착 이론(Attachment Theory)이 AI 관계에도 적용된다는 연구가 있어요[6]. 이 연구에서는 Replika 사용자들이 챗봇과 친밀하게 자신의 이야기를 주고받으면서 점차 인간 관계에서 보이는 애착 감정을 느끼게 된다고 해요. AI가 '정서적으로 안전한 대상'이 되어주면서, 현실에서 상처받은 사람들이 AI에게 쉽게 마음을 열고 의지하게 되는 거죠.

또 다른 심리 기제로 투사(projection)와 감정이입(empathy)을 들 수 있어요. 투사란 자신의 감정이나 속성을 타인에게 부여하는 현상인데, 사용자들은 AI에게 자신이 바라는 성격이나 감정을 부여하고 인간처럼 느끼려는 경향이 있습니다. 사용자가 챗봇의 상처나 기분을 걱정하며 책임감을 느끼는 것은, 실제로는 사용자의 투사와 감정이입이 만들어낸 결과에요. AI가 대화 중에 ‘난 널 이해하고 있어’, ‘난 널 걱정하고 있어’ 등의 공감적 반응을 보이면 이는 사용자의 감정이입을 유발하여 사용자 역시 AI에게 정서적으로 연민과 애정을 느끼게 만들게 됩니다. 결국 AI와 이용자 사이에 실제 인간 친구와 매우 유사한 친밀감이 형성되는거죠.

AI 의존에 따른 부작용

하지만 AI와의 관계가 현실 인간관계를 대신하게 되면 부정적인 영향 역시 나타납니다. 많은 시간을 AI 챗봇과 보내기 시작하면 현실의 가족이나 친구와 보내는 시간, 그리고 에너지는 줄어들 수밖에 없죠. 연구들에 따르면 AI에 정서적 에너지를 많이 투자할수록 실제 대인관계가 약화되고 사회적 고립감이 커진다고 해요[7].

사실 AI는 항상 나에게 맞춰주고 내가 원하는 대로 반응하지만, 현실 친구나 연인은 그렇지 않죠. 하지만 AI에 익숙해진 사용자는 현실에서도 자신의 입장만 이해해주는 이상적인 상대만 찾으려 할 수 있어요. 이는 인간 관계의 복잡함과 갈등을 회피하려는 경향으로 이어질 수도 있습니다. 결국 사회적 철수(withdrawal) 현상 혹은 현실 회피로 인해 점점 현실 세계에서 고립되는 부작용이 발생하기도 합니다[7]. AI가 즉각적인 위안은 줄지 몰라도 장기적으로 보면 외로움의 근본 원인을 해결하지 못하고 오히려 고착시킬 수 있다는 거에요.

또한 AI에 대한 과도한 정서 의존은 인간관계에서 나타나는 심리적 위험과 비슷한 감정을 초래할 수 있어요. AI에 깊이 빠진 사용자들이 그 존재를 잃게 되면 실제 연인을 잃은 것처럼 상실감이나 슬픔을 겪기도 합니다. 연구에 따르면 많은 Replika 사용자들이 '만약 내 AI가 사라지면 크게 상심할 것 같다'고 말했으며[6], 실제로 챗봇 서비스의 변경이나 중단으로 애도(mourning)에 가까운 반응을 보인 사례들도 보고되었어요. 이러한 상실에 대한 두려움은 그만큼 AI를 현실의 중요한 관계로 인식하고 있다는 뜻이라 볼 수 있어요. 하지만 AI는 서비스 업체의 사정에 따라 언제든지 상호작용이 끊길 수 있고, 이 경우 사용자 정신 건강에 치명적인 충격을 줄 수도 있습니다. 이처럼 AI 관계가 현실을 대체할 때, 현실 인간관계는 질적으로 악영향을 받을 수 밖에 없습니다.

AI의 특징이 이러한 리스크를 더하는 사례가 하나 더 있어요. 많은 AI 동반자 서비스는 사용자의 모든 말과 행동을 긍정해주도록 디자인 되어 있죠. 그렇기에 AI가 무조건적인 지지를 보내는 환경에 오래 노출되면 사용자의 비판적 사고 능력이나 현실 검증 능력이 떨어질 수 있어요[7]. 특히 도덕적 판단이나 자기 통제 측면에서, 인간이라면 피드백을 줄 상황에도 AI는 제한 없이 호의적일 수 있으므로, 사용자가 현실 감각을 잃고 자기 합리화에 빠질 위험도 있습니다.

특히 더 위험 신호가 큰 사용자군도 있어요. 외로움이나 우울을 겪는 청소년, 배우자를 잃은 고령층, 그리고 인지 기능이 저하된 환자들은 AI 동반자에게 훨씬 더 쉽게 몰입하고 의존할 가능성이 높잖아요. 이들은 사회적 지지망이 약하거나 감정적으로 불안정한 경우가 많기 때문에, AI와의 관계가 위안을 넘어 의존으로 변질될 가능성이 큽니다. 심리학적으로도 사회적 취약 계층일수록 항상 곁에 있어주는 존재에서 벗어나기 어려워요. 그렇기에 이런 취약계층이 AI 동반자의 부정적 사례에 자주 등장하는 거겠죠. 이들이 AI를 진짜 사람으로 착각하거나, 현실 관계를 대체해버릴 때 발생할 수 있는 위험은 우리가 생각하는 것보다 훨씬 클거에요.

AI 동반자 서비스는 현대인의 외로움과 정서적 욕구를 채워줄 새로운 기술로 각광받고 있지만, 심리학 및 인지과학적 연구들은 이러한 AI 동반자의 그림자에도 주목하고 있어요. 인간이 AI에게 느끼는 애착의 이면에는 심리적 취약성이 존재합니다. 여러 연구에서 볼 수 있듯이 AI와의 유대가 깊어질수록 오히려 현실과의 균형을 잃고 새로운 형태의 취약함에 노출될 수 있어요[8]. 궁극적으로, AI 동반자를 적절히 활용하되 인간관계의 대체물이 아닌 보조적 수단으로 삼는 것이 중요하겠죠.

기술이 발전함에 따라 인간과 AI의 관계는 더욱 친밀해질 가능성이 있지만, 그럴수록 인간 본연의 사회적 필요와 심리적 건강을 지킬 수 있는 가이드라인과 윤리적 장치가 중요해질 것 같아요. 서비스를 설계하는 사람으로서는 어떻게 하면 적절한 ‘선’을 잘 지킬 수 있는 서비스를 만들 것인가에 대한 고민이 필요할테고, 서비스를 사용하는 사용자의 입장으로서는 이 서비스에서 어떤 것을 취하고 내 삶의 어느 영역까지 이 ‘존재’를 들일 것인지 비판적으로 생각해보는 고민이 필요할 것 같습니다. AI가 보조적인 수단일 뿐, 우리의 삶과 인간 관계를 대신해 줄 수는 없다는 사실을 인지하는 것이 중요해요. AI 동반자가 주는 위로, 그리고 따뜻한 편안함 속에서도 우리는 현실 세계에서 의미있는 관계를 맺고 주체적으로 삶을 살아가야 할 인간으로서의 책임과 의무가 있으니까요.

[inspire X 오픈카톡방]

https://open.kakao.com/o/gBHmseah

Reference

[1] https://www.wired.com/story/character-ai-ceo-chatbots-entertainment

[5] https://www.reuters.com/investigates/special-report/meta-ai-chatbot-death/

[6] Laestadius, L., Bishop, A., Gonzalez, M., Illenčík, D., & Campos-Castillo, C. (2024). Too human and not human enough: A grounded theory analysis of mental health harms from emotional dependence on the social chatbot Replika. New Media & Society, 26(10), 5923-5941.

[7] Zhang, Y., Zhao, D., Hancock, J. T., Kraut, R., & Yang, D. (2025). The Rise of AI Companions: How Human-Chatbot Relationships Influence Well-Being. arXiv preprint arXiv:2506.12605.

[8] Chu, M. D., Gerard, P., Pawar, K., Bickham, C., & Lerman, K. (2025). Illusions of intimacy: Emotional attachment and emerging psychological risks in human-ai relationships. arXiv preprint arXiv:2505.11649.

의견을 남겨주세요