🧐 Summary

1️⃣ 금융, 의료와 같이 민감한 정보를 다루는 분야일수록 AI가 왜 그런 결정을 내렸는지 이해해야 AI가 제시한 결과를 신뢰하고 선택할 수 있습니다.

2️⃣ 지금은 AI의 의사결정을 기술적으로 이해하려는 두 가지 시도가 있습니다. 어떤 부분을 보고 그렇게 판단했는지, 어떤 과정을 통해 그렇게 판단했는지.

3️⃣ AI의 의사결정을 무조건 자세하게 설명하는 것은 의미가 없어요. 사용자 특성에 맞게 설명 수준을 조절하고 필요할 때 간결한 설명을 제공해야 합니다.

안녕하세요, 구독자님! 이번 주도 잘 보내셨나요?

이번 주에도 닥터 J, 닥터 G, 인턴 Nova가 함께 AI에 관한 뉴스레터를 준비했습니다. 가을의 낙엽이 지던 지난 주와 달리, 이번 주는 영하의 추위가 찾아왔네요. 이렇게 예측하기 어려운 날씨처럼 AI의 의사결정 과정도 종종 불분명합니다. AI가 왜 특정한 답을 내놓는지 이해하기 위해, 이번 주엔 설명 가능한 AI(XAI)와 이를 위한 UX 디자이너의 역할에 대해 알아보겠습니다.

설명 가능한 AI(Explainable AI, XAI)가 왜 필요해요?

AI는 때때로 예측 불가능하고, 이해하기 어려운 결정을 내릴 수 있습니다. 예를 들어, 구글 포토가 흑인 여성의 사진을 고릴라로 잘못 분류한 사건은 큰 논란을 일으켰습니다. 이처럼 AI의 오류는 심각한 사회적, 윤리적 문제를 일으킬 수 있습니다. 이러한 사건을 방지하고, AI 시스템의 결정을 이해하고 개선하기 위해서는 AI의 결정 과정을 설명할 수 있는 기술이 필요합니다.

예를 들어, 환자의 데이터를 분석하여 암 진단을 내리는 AI 시스템이 있다고 가정해 봅시다. 이 시스템이 어떤 데이터를 중요하게 고려하는지, 왜 특정 진단을 내렸는지를 이해할 수 있어야만, 의료 전문가들이 AI의 결정을 기반으로 적절한 치료 방법을 정하고 환자에게 설명할 수 있습니다.

AI가 왜 그런 결정을 내렸는지 사용자가 이해할 수 있다면 AI 시스템을 더 잘 활용할 수 있겠죠. 특히 금융, 의료, 법률 등 신뢰와 안전이 중요한 분야일수록 XAI가 꼭 필요합니다.

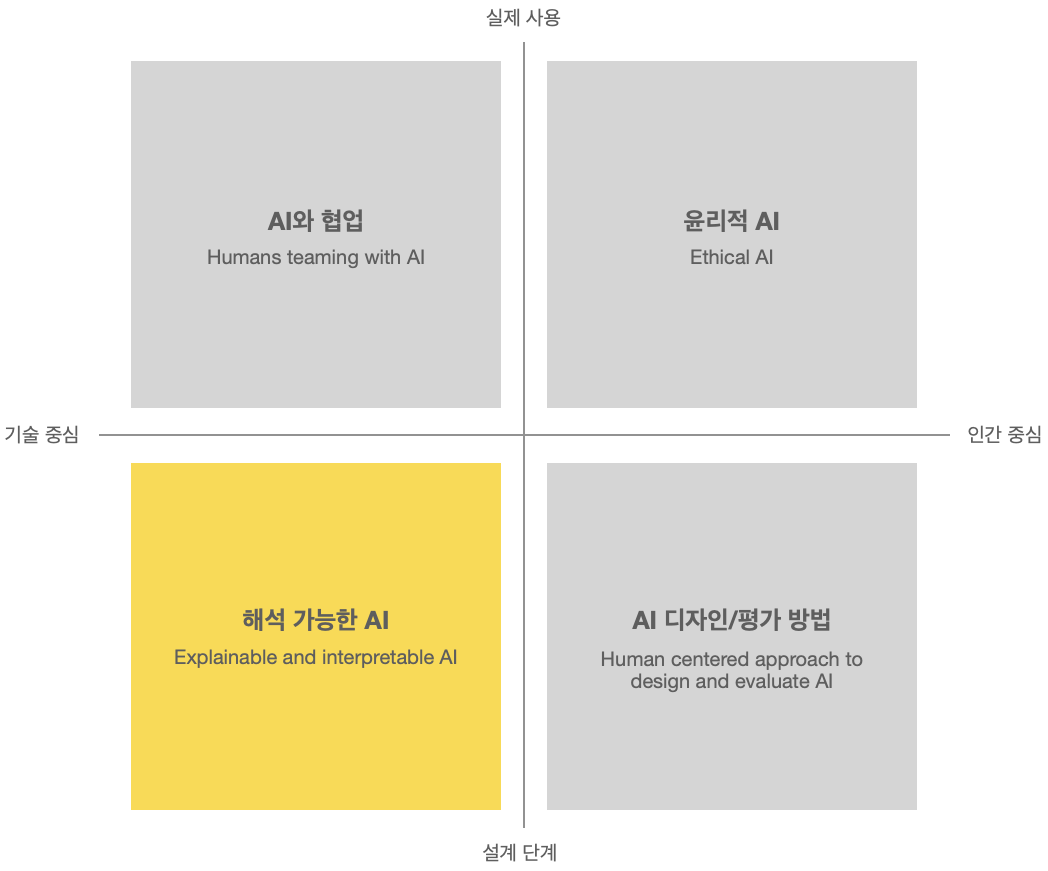

AI 블랙박스를 설명하는 기술적 접근

머신러닝 기반의 AI는 종종 '블랙박스'로 비유됩니다. AI가 어떻게 작동하는지, 왜 특정한 결정을 내렸는지 명확하게 이해하기 어렵기 때문입니다. 이러한 문제를 해결하기 위해 다양한 설명 가능한 AI 기술과 기법이 연구 중입니다. 크게 로컬 XAI 방법론과 글로벌 XAI 방법론으로 나눠볼 수 있습니다.

로컬 XAI는 특정 결정이나 결과에 대한 설명을 제공합니다.

- LIME (Local Interpretable Model-agnostic Explanation) : 구글 포토가 제 얼굴을 돼지로 인식했어요. 제 얼굴이 돼지가 된 사연을 이해하기 위해서, LIME은 제 얼굴과 비슷한 가짜 데이터를 여러 개 만듭니다. 어떤 데이터는 사람으로 분류가 되고 어떤 데이터는 돼지로 분류가 되겠죠. 이 때 어떤 데이터 특성이 이 분류에 가장 중요하게 작용했는지를 추론해서 설명해주는게 바로 LIME이에요. “음, 알아보니까 너 얼굴이 동그랗고, 콧구멍이 커서 돼지로 분류가 되었어” 얼굴형과 콧구멍 크기라는 데이터 특성이 사람과 돼지를 가르는 중요한 요소였다는 추론을 한거죠.

글로벌 XAI는 AI 모델 전체의 작동 방식을 설명하는 데 초점을 맞춥니다.

- PDP (Partial Dependence Plot) : 식습관 데이터를 넣으면 비만이 될 확률을 예측해주는 모델이 있다고 했을 때, 어떤 식습관 데이터로 인해 비만 확률이 높아지는지 이 모델 전체를 설명해주는 방식이에요. 식습관 데이터 중 일일 당 섭취량이라는 변수에 대해 알고 싶다면, 다른 변수는 모두 고정시키고 일일 당 섭취량만 조금씩 바꿔보면서 비만 확률이 어떻게 변화하는지 보는거에요. 간단하게 모델을 설명할 수 있다는 장점이 있지만, 만약 일일 당 섭취량과 직접적인 상호작용이 있는 다른 변수가 있다면 그 효과는 알 수 없다는 단점도 있어요.

AI 블랙박스를 설명하기 위한 UX의 노력

AI시스템의 작동방식을 투명하게 설명해준다면 모든 문제가 해결될까요?

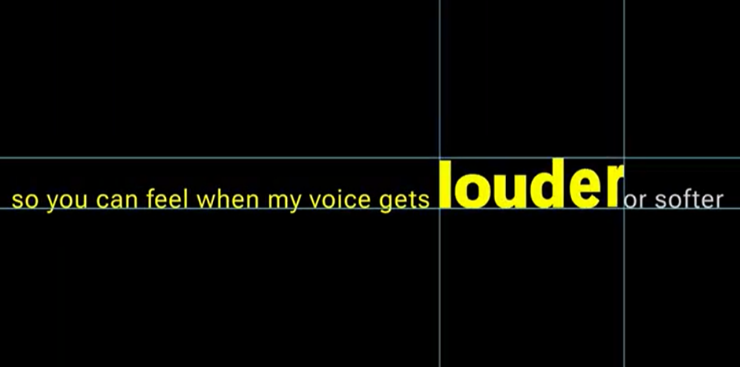

1. 사용자가 필요로 할 때 간결하고 명확한 정보를 제공해야 합니다

2022년에 발행된 지능형 차량의 인포테이먼트 시스템에 대한 XAI 연구에서는 간단한 정보만 제공하는 인포테이먼트 시스템과 자세한 설명을 제공하는 인포테인먼트 시스템에 대해 사용자 조사를 진행했습니다. 자세한 설명을 제공하는 인포테인먼트 시스템은 이해 가능성과 예측 가능성에서 높은 점수를 받았지만 만족도는 낮았습니다. 그저 자세한 설명보다는 사용자가 요청할 때 간결하게 제공되는 정보가 더 좋을 수 있는것이죠 [1].

2. 사용자의 특성에 따라서 설명의 수준을 조절해야 합니다

의료 분야에서 사용되는 AI 시스템을 일반인과 의료 전문가가 사용한다면, 그들에게 제공되는설명의 수준과 내용은 달라야겠죠.

현재 XAI 연구는 AI 시스템의 의사결정 과정을 기술적으로 설명하도록 하는 데 중점을 두고 있지만, 앞으로는 사용자가 AI 시스템에 대한 설명을 단순히 받아들이는 것이 아니라 상호작용할 수 있는 방향으로 발전할 것입니다. 이를 위해서는 UX 디자이너도 AI 시스템을 잘 이해해야 합니다. AI가 할 수 있는 것과 할 수 없는 것을 구분할 줄 알아야 사용자에게 AI의 '무엇을, 어떻게 설명할 것인가'를 결정하고 설명 내용에 맞는 정보 표시 방식을 설계할 수 있을테니까요.

오늘의 뉴스레터를 통해 설명 가능한 AI와 UX 디자이너의 역할에 대해 조금 더 깊이 이해하셨기를 바랍니다. AI의 세계는 끊임없이 변화하고 발전하고 있으며, UX 디자이너와 연구자들은 사용자들이 AI의 작동방식을 잘 이해할 수 있도록 도와야 합니다.

다음 주에도 새로운 정보와 통찰을 가지고 여러분을 찾아뵙겠습니다. 한 주 동안 건강하고 행복하게 지내시길 바랍니다. 다음 뉴스레터에서 만나요!

🤔 InspireX의 물음표

댓글이나 이메일로 여러분의 생각을 들려주세요!😉

Q1. 어떻게 AI의 복잡한 의사결정 과정을 더 투명하고 이해하기 쉽게 만들 수 있을까요?

Q2. AI의 기술적 복잡성을 사용자에게 명확하게 전달하는 것과 사용자 경험을 해치지 않으면서 필요한 정보를 제공하는 것 사이의 균형을 어떻게 찾을 수 있을까요?

Reference

[1] Graefe, J., Paden, S., Engelhardt, D., & Bengler, K. (2022, September). Human Centered Explainability for Intelligent Vehicles–A User Study. In Proceedings of the 14th International Conference on Automotive User Interfaces and Interactive Vehicular Applications (pp. 297-306).

의견을 남겨주세요