🧐 Summary

1️⃣ AI는 사실을 검증하기보다 그럴듯함을 만들어내는 데 능숙하기 때문에 인간의 신뢰를 쉽게 얻을 수 있어요.

2️⃣ 우리는 AI를 쓰면서 점점 스스로 점검하고 의심하는 습관을 잃어버리면서 ‘생각하는 일’을 AI에게 넘겨버리고있어요.

3️⃣ 우리에게 필요한 건 완벽한 AI가 아니라, 그 한계를 인식하고 함께 배우는 인간이에요.

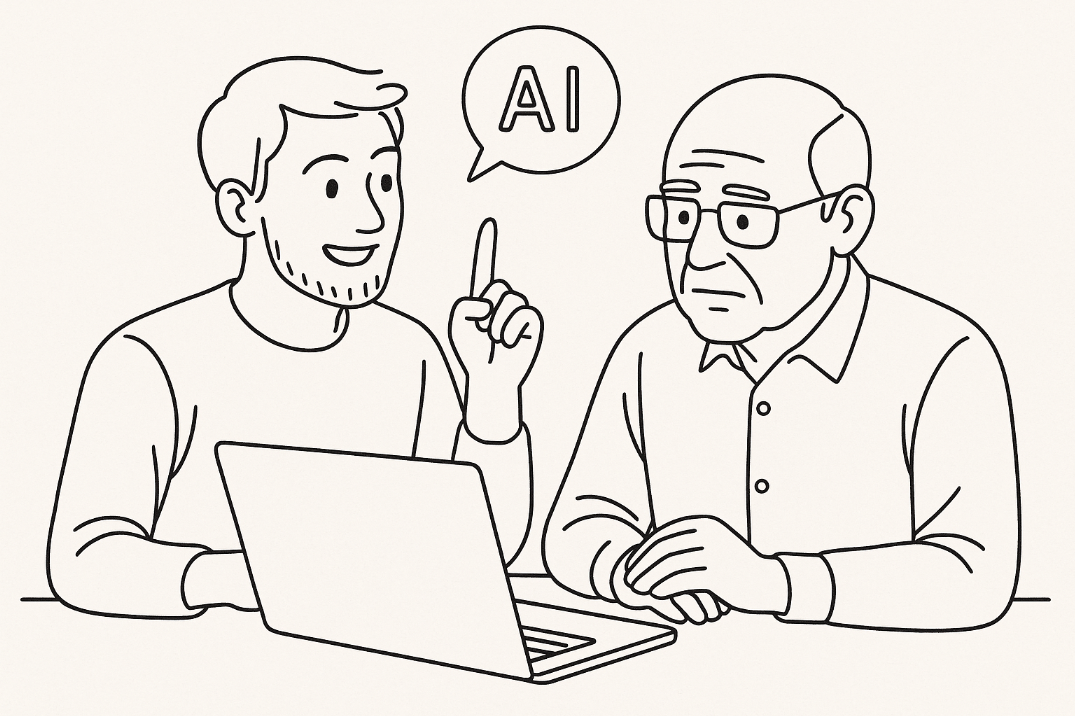

회사에서 새로운 프로젝트를 준비하면서 ChatGPT로 자료조사를 했던 적이 있어요. AI는 논문 제목부터 저자, 발행 연도, 주요 결과까지 척척 말해줬죠. 너무나 논리적이고 확신에 찬 말투로요. 그런데 뭔가 이상한 예감이 들어 링크를 눌러봤더니, 그런 논문은 존재하지 않았습니다.

순간 두 가지 감정이 차례로 올라왔습니다. “왜 또 틀린 정보를 그럴듯하게 말하는 거야?” 하는 짜증, 그리고 “나는 왜 그걸 믿었지?”라는 의문. 생각해보면 문제는 기술이 아니라 ‘AI는 똑똑할 거야’라는 내 믿음과 AI의 자신감 넘치는 태도였습니다. 사실, 믿을 수 밖에 없잖아요. 너무 그럴듯하게 들리니까요.

그래서 오늘은 AI 여전히 왜 이렇게 그럴듯하게 틀리는지, 그럴때 우리는 어떻게 AI를 대해야하는지 알아보겠습니다.

AI는 왜 그렇게 자신만만할까

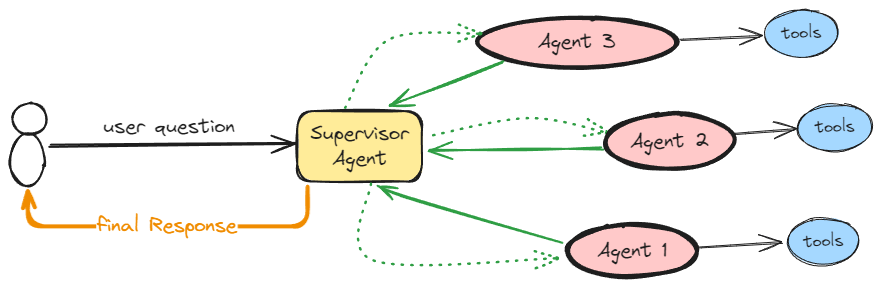

AI는 사실 여부를 검증하기보다, ‘그럴듯하게 말하기’에 능숙한 존재입니다. 대형 언어 모델(LLM)은 “이건 확실합니다” 혹은 “잘 모르겠어요”처럼 자신감(confidence) 을 표현할 수 있어요. 연구에 따르면, “확실하다”고 말할 때 실제로 맞을 가능성이 조금 더 높긴 하지만, 그 자신감은 자주 과장되어 있습니다.

왜그럴까요? AI는 내부적으로 “이 답이 맞을 확률이 얼마나 될까?”를 계산하지만, 사람처럼 경험을 바탕으로 배우기는 어렵습니다. 우리는 한 번 실수하면 다음엔 조심하지만, AI는 그럴 수 없어요. 한마디로 아직 AI에게는 “다음엔 더 신중해야지”라는 개념이 없습니다. 그래서 AI의 확신은 매번 새로 계산되는 일회성 판단일 뿐이에요.

이전의 실수를 기억하지 않기 때문에, 같은 질문이 다시 와도 여전히 똑같이 자신 있게 답합니다. 그런데 그 자신감이 항상 정확한 건 아닙니다. 정답이 분명한 상식 문제에서는 그 확신이 꽤 잘 맞지만, 미래 예측처럼 불확실한 문제에서는 틀릴 가능성이 높아도 여전히 “맞을 거예요”라고 말합니다.

이런 AI의 ‘자신감’은 신뢰의 기준이 아니라 착각의 근거가 되기도 합니다. 논리적이고 매끄러운 말투 덕분에 사람들은 “이건 확실하겠지”라고 느끼지만, 그 확신은 종종 통계적으로 불완전한 계산의 결과일 뿐이에요.

인간은 왜 AI의 오류를 못 알아차릴까

AI가 자신 있게 틀리면, 대부분의 사람은 그걸 눈치채지 못합니다. 아이러니하게도 이유는 AI의 교묘함이 아니라 우리의 습관 때문이에요.

요즘 우리는 AI를 쓰면 결과물이 더 좋아지는 경험을 합니다.. 기획안이 매끄러워지고, 글의 완성도도 높아지죠. 그런 성공이 반복되면 점점 AI의 판단을 검증하지 않게 됩니다.

원래 사람은 계획을 세우고, 스스로 점검하고, 평가하는 과정을 통해 배웁니다. 그런데 AI가 대신 생각하기 시작하면, 사람은 그 과정을 생략하죠. 연구자들은 이런 현상을 ‘메타인지적 게으름’이라고 부릅니다.

한마디로, ‘생각하는 일’을 AI에게 맡겨버리는 거예요. 이 습관은 금세 강화됩니다. “설마 AI가 틀리겠어?”, “이미 알아서 검토했겠지.” 의심이 줄어들면서 우리는 점점 판단자가 아니라 결과만 소비하는 사람이 됩니다.

2025년 발표된 한 실험에서는 65%정도가 AI가 제시한 잘못된 정보도 그대로 믿었다고 해요. 물론 이 실험은 실제 사람을 대상으로 하지않은 합성데이터 기반의 가상실험이었지만 일상에서도 이런 일이 쉽게 일어납니다. 이건 우리의 인지적 편향 때문이에요. “AI가 말했으니 맞겠지”, “다들 쓰니까 괜찮겠지”, “귀찮으니까 그냥 넘어가자.” 이런 생각들이 바로 우리가 흔히 빠지는 착각이죠.

결국 AI가 나보다 똑똑하겠지라는 막연한 믿음이 우리를 비판적 사고에서 멀어지게 만듭니다. AI의 오류를 알아차리지 못하는 이유는, AI의 교묘함이 아니라 우리의 생각하는 습관이 무뎌진 탓이에요.

오류를 알아차린 후 신뢰의 변화

AI가 틀렸다는 사실을 알게 된 사람들의 반응은 극단적으로 나뉩니다. “역시 믿을 수 없어”라며 신뢰를 끊는 사람, “이 정도면 인간도 실수하지”라며 받아들이는 사람. 이 과정을 신뢰 보정이라고 부릅니다.

한 연구에서는 AI가 자신 있게 말하더라도 실제로는 틀릴 수 있다는 사실과, AI의 정답률을 함께 보여줬어요. 그랬더니 사람들은 “이 AI가 자신감은 있지만 완벽하진 않구나”라는 걸 더 잘 이해했죠.

그런데 흥미롭게도, 이런 정보를 자주 접한 사람일수록 점점 AI를 덜 믿게 됐습니다. 양치기 소년 동화 아시죠? 계속 틀리는 걸 보다 보면, 나중엔 아무리 “이번엔 진짜야!”라고 말해도 믿기 어려운 것과 비슷한 거예요.

AI의 오류를 보여주는 건 중요하지만, 그걸 너무 자주 경험하게 하면 ‘신뢰’ 자체가 무너집니다. 결국 중요한 건 균형이에요. AI를 설계할 때는 오류를 보여줄까 말까의 문제가 아니라, 언제 믿고 언제 의심해야 하는지를 사용자가 자연스럽게 배울 수 있도록 돕는 일이 중요합니다. 신뢰를 만들어가는 것은 AI를 지나치게 믿지도, 지나치게 의심하지도 않도록 적당한 거리에서 함께 일하는 방법을 배우는 과정입니다.

그동안 AI 연구는 ‘AI가 틀리지 않게 만드는 것’에 초점을 맞춰왔어요. 하지만 현실에서는 사람도, 기술도 완벽할 수 없죠. 그래서 중요한 건 AI가 실수했을 때, 그걸 함께 찾아내고 고쳐가는 경험이에요. 앞으로의 협업은 바로 그 방향으로 나아가야 합니다.

우리가 진짜로 필요로 하는 건 모든 정답을 아는 AI가 아니라, AI의 한계를 이해하고 비판적으로 바라볼 줄 아는 인간이에요. AI가 아무리 정교해져도 우리가 생각하는 힘을 잃는다면, 결국 ‘생각을 대신해주는 기술’에 의존하게 될테니까요. 그래서 미래의 협업은 완벽한 AI보다, 함께 틀리며 배우는 관계로 가야 합니다.

오늘은 저도 AI에게 화내지 말고, 그 오류를 함께 다뤄보려 해요. 기술도 완벽하지 않다는 걸 인정하는 연습, 어쩌면 이번 주 우리에게 꼭 필요한 태도일지도 모릅니다.

그럼 우리는 새로운 이야기로 다음주 수요일에 만나요!

[inspire X 오픈카톡방]

https://open.kakao.com/o/gBHmseah

Reference

[1] Cash, T. N., & Oppenheimer, D. M. (2025). Quantifying uncert-AI-nty: Testing the accuracy of LLMs’ confidence judgments. Memory & Cognition. https://doi.org/10.3758/s13421-025-01755-4

[2] Leidenfrost, T., Baehr, J., Vanhove, J., & Reis, O. (2024). Beware of metacognitive laziness: Effects of generative artificial intelligence on learning motivation, processes and performance. British Journal of Educational Technology. https://doi.org/10.1111/bjet.13544

[3] Bertoncini, A. L., Matsushita, R., & Da Silva, S. (2025, October). AI, Ethics, and Cognitive Bias: An LLM-Based Synthetic Simulation for Education and Research. AI in Education, 1(1), 3. MDPI. https://doi.org/10.3390/aieduc1010003

[4] Li, J., Yang, Y., Zhang, R., & Lee, Y.-C. (2024). Overconfident and unconfident AI hinder human-AI collaboration. arXiv. https://arxiv.org/abs/2402.07632

의견을 남겨주세요