🧐 Summary

1️⃣ 인간과 로봇의 인터랙션에서 로봇의 외형적 디자인이나 얼굴 표정, 시선 처리가 인간의 인식에 영향을 줄 수 있어요.

2️⃣ 로봇의 눈맞춤은 인간과 로봇의 인터랙션에서 만족도 및 신뢰감을 높여주는 요소입니다.

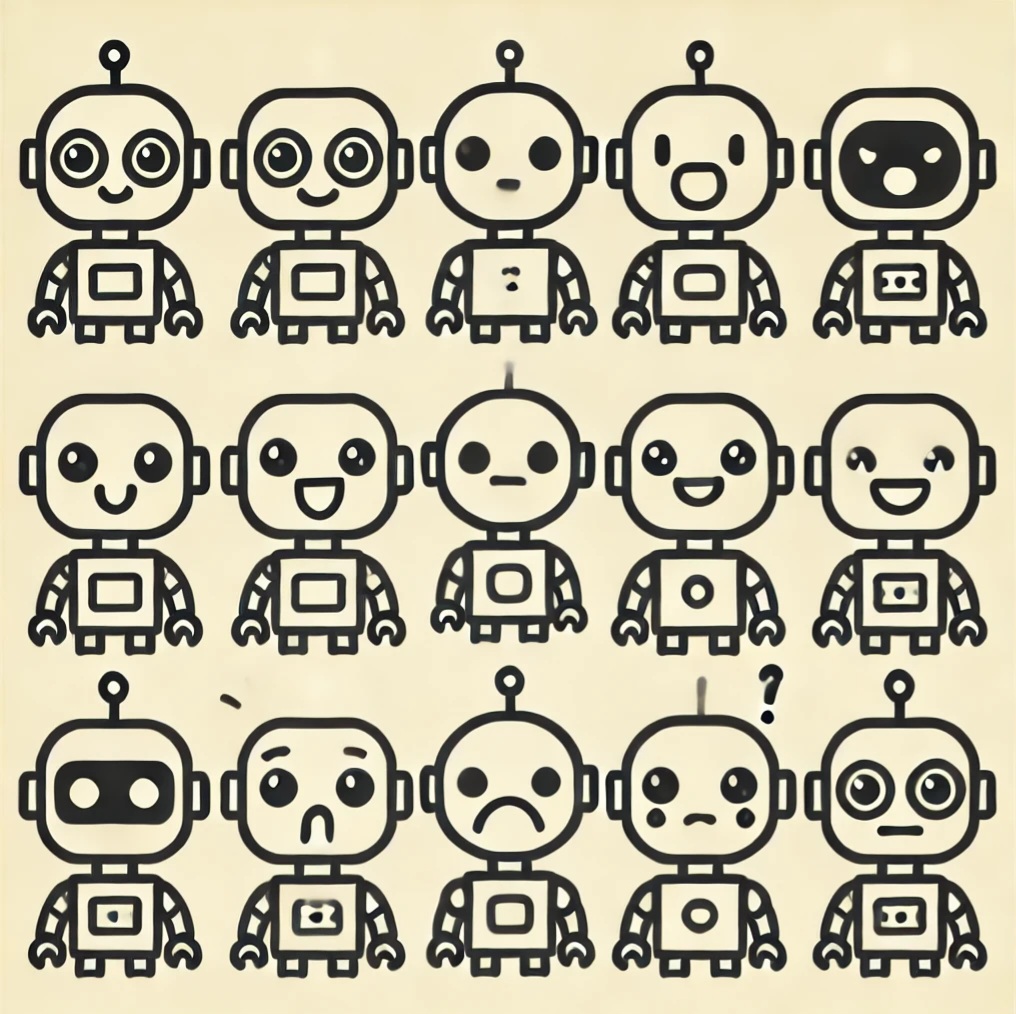

3️⃣ 사람의 얼굴 표정을 구현하는 데에 관계있는 근육의 움직임을 모방하여 로봇의 표정을 다양하고 정교하게 디자인할 수 있어요.

안녕하세요 구독자님. 혹시 트렌드 코리아 2025 나온거 보셨나요? 벌써 2025년 트렌드라니… 2024 트렌드 조사해서 뉴스레터 발행한게 엊그제 같은데 어느새 2024년이 끝나가고 있나봐요.

2025 트렌드 중 FaceTech라는게 있더라구요. 다양한 기기들과 상호작용이 잦아진 시대에 이 기술들을 보다 사람들이 친숙하게 느낄 수 있도록 얼굴, 그리고 표정을 만들어내는 기술이 중요하다는 얘기였어요. 기기가 사람의 표정을 읽는 기술, 또 그에 적합한 인터랙션을 위해 기기 자체의 얼굴을 잘 만들어내는 기술 모두가 필요하다는 것이죠. 저희도 지난 주 뉴스레터에서 이모지의 중요성을 얘기했었는데, 이모지 그 이상의 얼굴과 표정을 뜻하는 이 FaceTech라는 트렌드가 재밌어서 오늘은 이 이야기를 좀 해보려 해요.

저는 얼마 전 출산을 해서 요즘 저의 모든 시간은 육아로 꽉 채워져 있는데요, 태어난지 얼마 안된 이 아가도 사람의 표정에 매우 민감하게 반응하는 것 같더라구요. 제가 아가에게 눈을 맞추고 이야기를 하면 무슨 말인지 못알아 듣더라도 함께 저에게 눈을 맞추고 반응하구요, 제가 함박웃음을 짓거나 과장된 표정을 지으면 그걸 보고 아가도 꺄르르 웃으며 반응을 해요. 이렇게 본능적으로 사람은 상대방의 표정에 주의를 기울이고 그 표정을 읽게 되는 것 같습니다. 그렇기에 사람과 상호작용 하는 기기들이 사람과 유사한 형태를 지니고 있다면 사용자는 그 표정에도 관심을 가지게 되나봐요.

메라비언 교수(Albert Mehrabian)의 저서 침묵의 메시지(Silent Messages)에서 주장하는 메라비언의 법칙 들어보신 적 있으신가요? 감정의 전달에서 단어가 차지하는 비율은 7%에 불과하고, 목소리의 톤이 38%, 그리고 얼굴 표정이 55%를 차지한다고 해요. 즉, 감정 표현은 말로 전달되는 것보다 비언어적 요소, 특히 표정을 통해 더 강력하게 전달된다는 거죠. 그럼 이 표정이라는 것이 사람 대 사람이 아닌, 사람과 다른 기기간의 인터랙션에서 어떠한 역할을 하는지 알아볼게요.

인간-인간 vs. 인간-로봇 인터랙션의 차이점

사람 대 사람의 상호작용 (HHI, Human-Human Interaction)과 사람 대 로봇의 상호작용 (Human-Non human Interaction)의 가장 큰 차이점은 인간의 반응 및 인지방식에서 나타납니다. Baka (2024)의 연구에서 저자는 인간이 로봇과 상호작용할 때 신체적 존재감 및 비언어적 신호의 부족으로 인해 상호작용의 자연스러움이 떨어질 수 있다고 지적하고 있어요. 또한 로봇은 문화적 맥락에 따른 적응이 어렵기에, 인간과 달리 사회적 신호에 유연하게 반응하지 못하죠. 이런 한계로 인해, 사람들은 로봇과의 상호작용에서 긴장감을 느끼거나 이 상호작용의 흐름이 조금은 어색하게 느껴질 수 있습니다. 특히, 로봇의 외형적 디자인이나 얼굴 표정, 시선 처리가 인간의 감정 인식에 영향을 미치기 때문에, 이러한 요소들을 잘 디자인한다면 사람과 로봇의 상호작용을 개선하는 데에 큰 역할을 할 수 있어요.

로봇과 사람의 눈맞춤

Fang et al.(2024) 의 연구에서는 비언어적 의사소통, 특히 눈맞춤이 인간 상호작용에서 매우 중요한 역할을 한다고 주장합니다. 그래서 로봇이 이러한 눈맞춤을 효과적으로 모방할 수 있는 방법을 제안하고, 이것이 얼마나 효과적인지 검증해보았어요.

이 연구에서는 로봇이 눈만 움직일 때 보다 눈과 머리를 함께 움직일 때에 사용자가 더 직접적으로 로봇의 시선을 인식한다는 것이 검증되었어요. 아무래도 눈이 움직이는 방향으로 머리도 함께 움직이면 로봇이 자신을 보고 있다는 더 강한 인상을 주기 때문이겠죠?

또한 Kaiser et al.(2024) 의 연구는 더 나아가 로봇의 시선이 사람과의 상호작용에서 신뢰와 만족도에 미치는 영향을 다룹니다. 특히, 로봇의 시선 처리 방식이 금융 자문과 같은 상담에서 어떻게 의사 결정에 영향을 미치는지를 분석합니다. 시선 처리를 이용해 단순히 감정을 전달하는 것을 넘어서, 신뢰도에도 영향을 준다는 것이죠. 이 연구는 다양한 형태의 시선 접촉이 상호작용의 질을 크게 좌우하며, 만족도에도 직접적인 영향을 준다고 설명합니다.

사람과 사람 사이에도 상대방이 나에게 얼마나 집중하고 있는지, 얼마나 진심인지를 알려주는 가장 큰 요소가 아무래도 눈빛, 눈맞춤 아닐까 싶어요. 이렇게 다양한 연구들은 로봇과 사람의 인터랙션에서도 눈맞춤, 시선의 중요성을 강조하고 있습니다.

로봇의 정교한 얼굴 표정 구현

찰스 다윈의 연구에 기반해 Ekman (2006)이 발전시킨 생물학적 표현 이론에 따르면, 인간의 얼굴 표정은 문화의 산물일 뿐만 아니라 서로 다른 문화와 종을 초월해 보편적이라고 해요. 다윈은 얼굴 표정이 종 내에서 의사소통 기능을 수행하도록 진화하여 감정 상태와 의도를 전달할 수 있게 되었다고 주장했죠. 그리고 Ekman (2006)은 다양한 문화를 대상으로 한 연구를 통해 행복, 슬픔, 두려움, 분노, 놀라움, 혐오, 경멸의 일곱 가지 기본 감정이 보편적인 얼굴 표정을 통해 표현된다는 것을 밝혔어요. 이러한 표정은 중추신경계, 특히 얼굴 신경과 40개 이상의 얼굴 근육에 의해 통제되어 복잡한 표정을 만들어낸다고 해요.

이 이론을 기반으로 Minh & Thinh (2024)는 로봇이 사람의 감정 표현을 자연스럽게 모방할 수 있도록 하여 인간-로봇 상호작용에서의 실감나는 경험을 만들기 위한 연구를 진행했습니다. 이 연구에서는 로봇의 감정 표현이 자연스럽게 이루어지는지 확인하기 위해 카메라와 센서를 통해 실시간 피드백을 제공하는 피드백 제어 루프를 사용하여, 이를 기반으로 오류를 최소화하고 감정 표현을 보다 정밀하게 개선했어요. 로봇이 목표한 감정을 정확하게 표현하도록 이 피드백을 기반으로 감정에 따른 모터의 회전 각도를 세밀하게 조정한거죠. 이를 통해 로봇은 사람과 거의 유사하게 다양한 표정을 정확하게 표현할 수 있었고, 자연스러운 상호작용 경험을 제공하였습니다.

오늘은 사람과 기기 사이의 인터랙션에서 표정이 중요한 이유, 그리고 그 표정을 구현해내는 방법에 대해 이야기해보았어요. 저도 이 글을 쓰면서 다시 한 번 인터랙션에서 표정이 차지하는 비중에 대해 생각해보게 되었네요. 예전에 로봇의 외형이 사람과 유사해짐에 따라 불쾌한 골짜기 현상이 나타나는 것에 대해 글을 쓴 적이 있었는데, 그 때도 이 현상을 피하기 위해 사람과 아예 똑같은 외형을 만드는 방법이 있다고 말씀드렸었죠. (여기를 참고해주세요) 오늘 이야기한 FaceTech는 이와 유사한 방법이에요. 사람과 거의 똑같은 수준의 표정을 구사하도록 하여 인터랙션을 더욱 자연스럽게 만들어주는거죠. 앞으로 이 분야의 연구는 더더욱 중요해지고 다양해질 것 같아요. 또 새로운 소식이 있으면 추가로 조사해서 알려드리도록 할게요!

사람과 사람의 인터랙션에서 아름답고 좋은 표정 많이 짓는 주말 보내시길 바라며, 다음주 월요일에 업계 소식으로 다시 만나뵈어요!

Reference

[1] Mehrabian, A. (1971). Silent messages.

[2] Baka, E. (2022). A Multimodal Approach for Identification, Analysis, and Comparison of Human Emotional and Behavioral Patterns between Human-Human and Human-Technology Interaction. [Doctoral thesis, University of Geneva] https://archive-ouverte.unige.ch/unige:173693

[3] Fang, Y., Pérez-Molerón, J. M., Merino, L., Yeh, S. L., Nishina, S., & Gomez, R. (2024). Enhancing social robot's direct gaze expression through vestibulo-ocular movements. Advanced Robotics, 1-13.

[4] Kaiser, C., Schallner, R., Manewitsch, V., & Fenne, E. (2024). The Role of Eye Contact in Human-Robot Interaction: Trust and Decision-Making in Virtual Financial Advisory.

[5] Ekman, P. (Ed.). (2006). Darwin and facial expression: A century of research in review. Ishk.

[6] Minh Trieu, N., & Thinh, N. T. (2024). Advanced Design and Implementation of a Biomimetic Humanoid Robotic Head Based on Vietnamese Anthropometry. Biomimetics, 9(9), 554.

의견을 남겨주세요